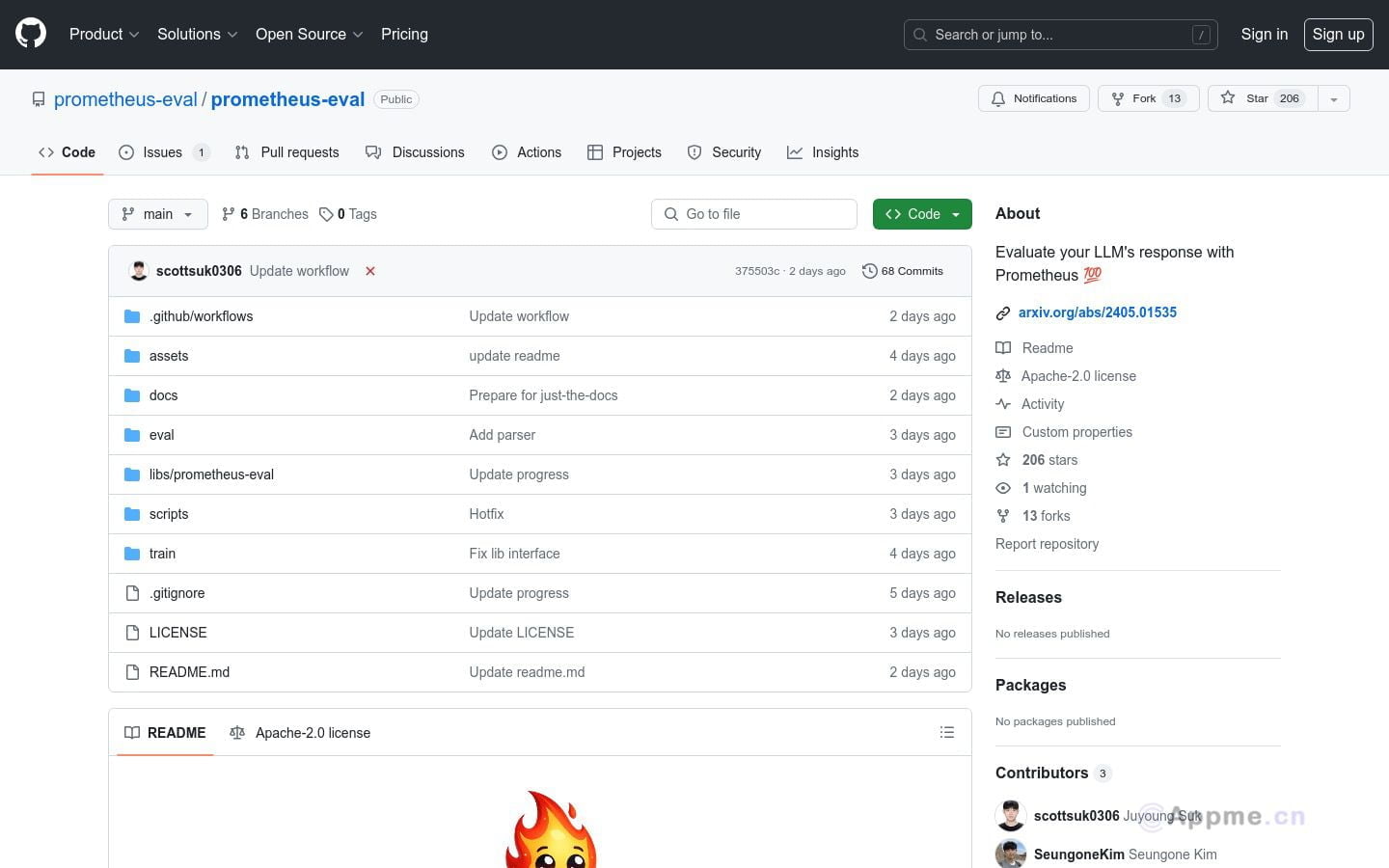

Prometheus-Eval 是一个用于评估大型语言模型(LLM)在生成任务中表现的开源工具集。它提供了一个简单的接口,使用 Prometheus 模型来评估指令和响应对。Prometheus 2 模型支持直接评估(绝对评分)和成对排名(相对评分),能够模拟人类判断和专有的基于语言模型的评估,解决了公平性、可控性和可负担性的问题。

需求人群: ["研究人员和开发者:用于评估和优化他们自己的语言模型","教育机构:作为教学工具,帮助学生理解语言模型的评估过程","企业:构建内部评估流程,不依赖闭源模型,保护数据隐私"] 使用场景示例: 评估一个语言模型在情感分析任务上的表现比较两个不同模型在文本生成任务中的优劣作为开发新语言模型时的测试基准 产品特色: 绝对评分:根据给定的指令、参考答案和评分标准,输出1到5的分数相对评分:基于给定的指令和评分标准,评估两个响应,输出’A’或’B’以表示更好的响应支持直接从 Huggingface Hub 下载模型权重提供 Python 包 prometheus-eval 用于简化评估过程包含训练 Prometheus 模型或在自定义数据集上微调的脚本提供评估数据集,用于训练和评估 Prometheus 模型支持在消费者级 GPU 上运行,减少资源需求 使用教程: 步骤1:安装 Prometheus-Eval Python 包步骤2:准备评估所需的指令、响应和评分标准步骤3:使用绝对评分或相对评分方法进行评估步骤4:根据输出的分数或等级,分析模型表现步骤5:根据评估结果调整和优化语言模型 展开 浏览量:18 s1785318098921236 打开站点