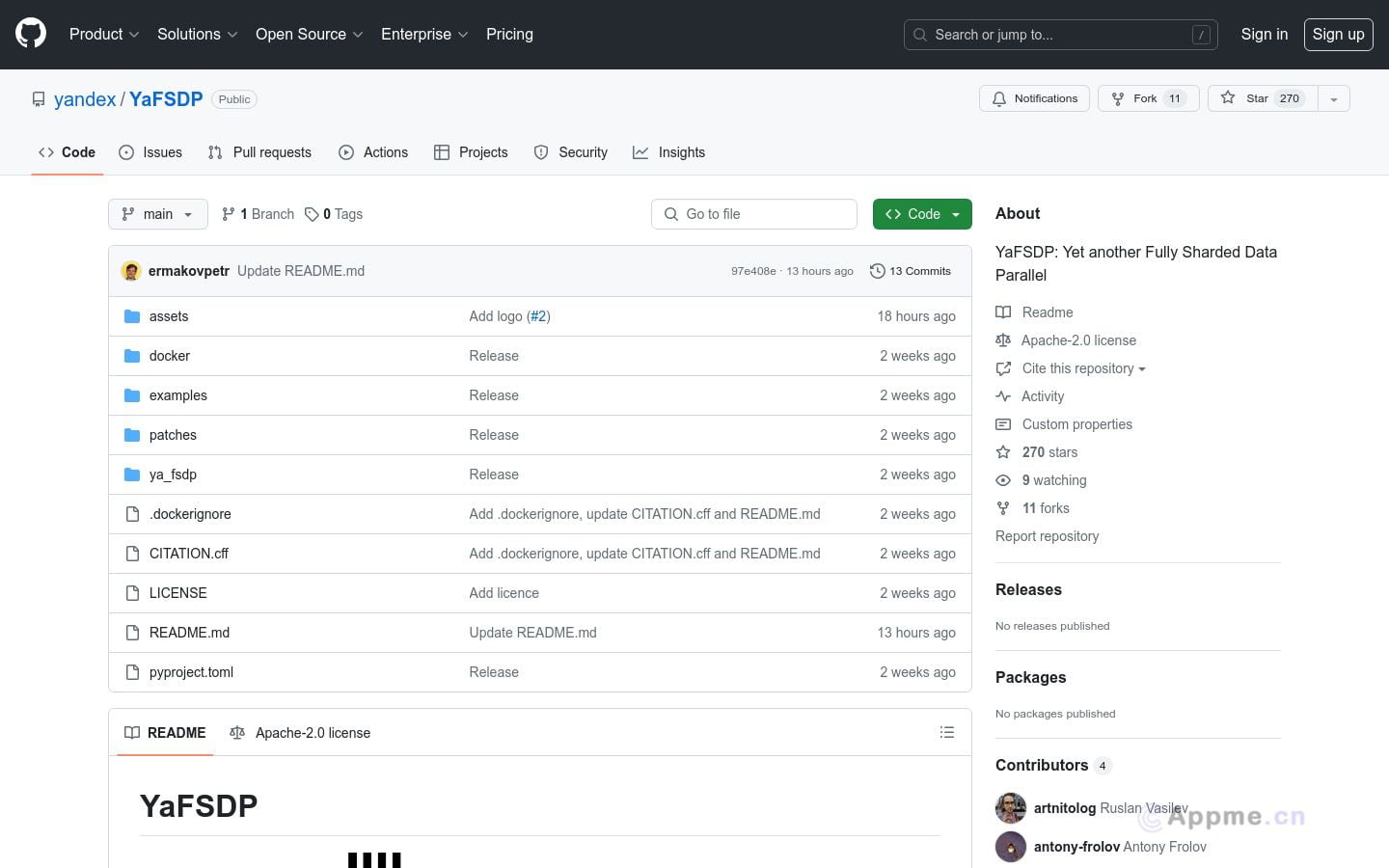

YaFSDP是一款专为transformer类神经网络设计的分布式数据并行框架。它在预训练大型语言模型时比传统FSDP快20%,尤其适合高内存压力环境。YaFSDP通过优化内存和通信操作,显著提高了训练效率。该框架支持7B至70B参数规模的模型训练,可在64至256个设备上并行运行,并支持处理长达8192个token的序列。

YaFSDP主要面向需要处理大规模数据和模型的机器学习研究人员和工程师。它为用户提供了详细的使用示例,包括因果预训练和监督微调,并支持自定义事件通知。基于NVIDIA PyTorch图像构建,YaFSDP集成了必要的补丁库,确保了框架的高性能和稳定性。

对于从事大型语言模型研究和应用的团队,YaFSDP能够显著提升训练效率,降低资源消耗,加速模型开发周期,从而推动人工智能领域的快速发展。