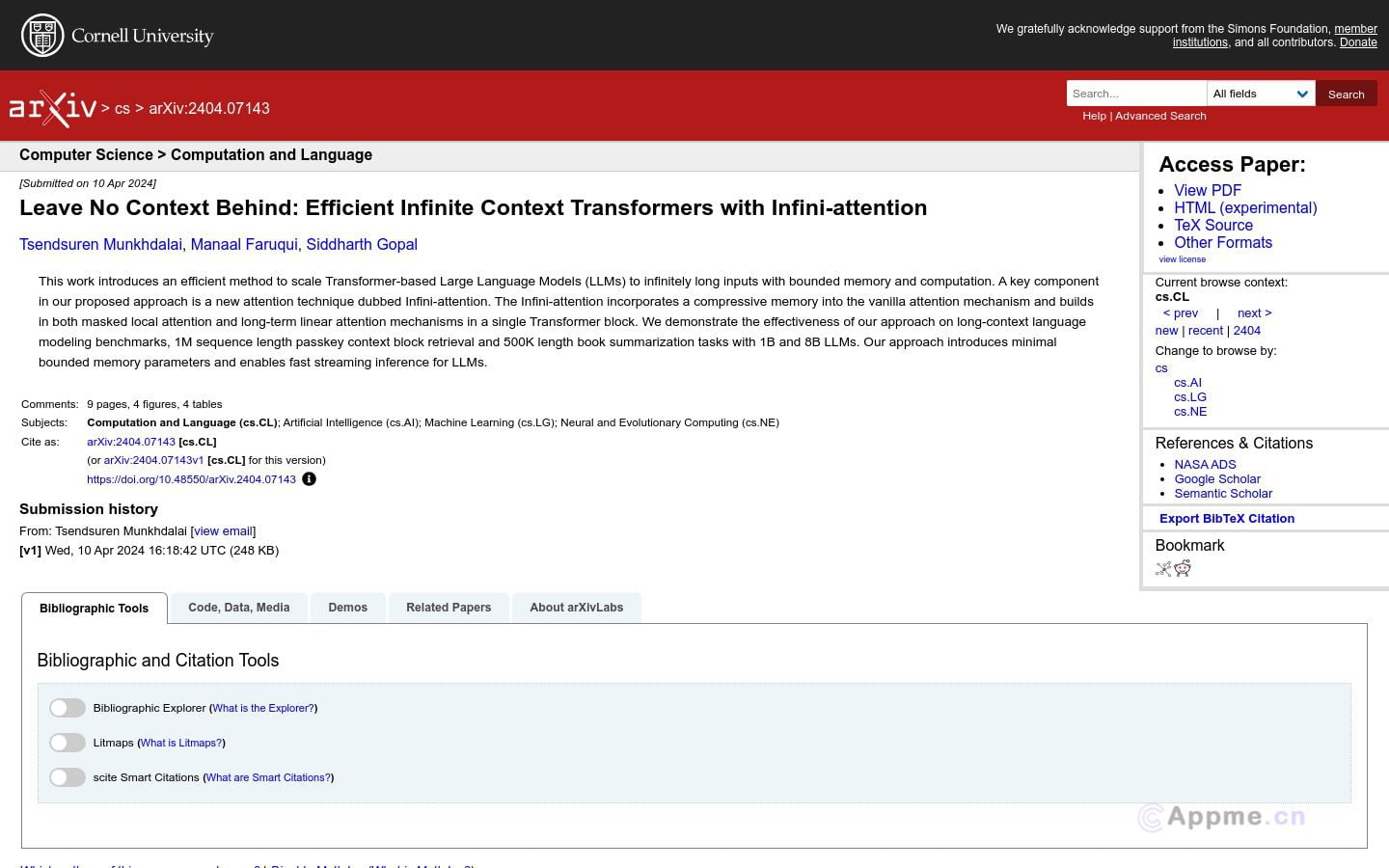

Google开发的“Infini-attention”技术旨在扩展基于Transformer的大语言模型以处理无限长的输入,通过压缩记忆机制实现无限长输入处理,并在多个长序列任务上取得优异表现。技术方法包括压缩记忆机制、局部与长期注意力的结合和流式处理能力等。实验结果显示在长上下文语言建模、密钥上下文块检索和书籍摘要任务上的性能优势。

需求人群: "适用于处理要求对长序列数据进行高效建模和推理的NLP任务。" 使用场景示例: 长文本生成:利用Infini-attention技术生成长篇文章。密钥检索:在处理长序列密钥上下文块检索任务中应用。文本摘要:处理长篇文本生成精炼的文本摘要。 产品特色: 压缩记忆机制局部与长期注意力结合流式处理能力支持快速流式推理模型扩展性