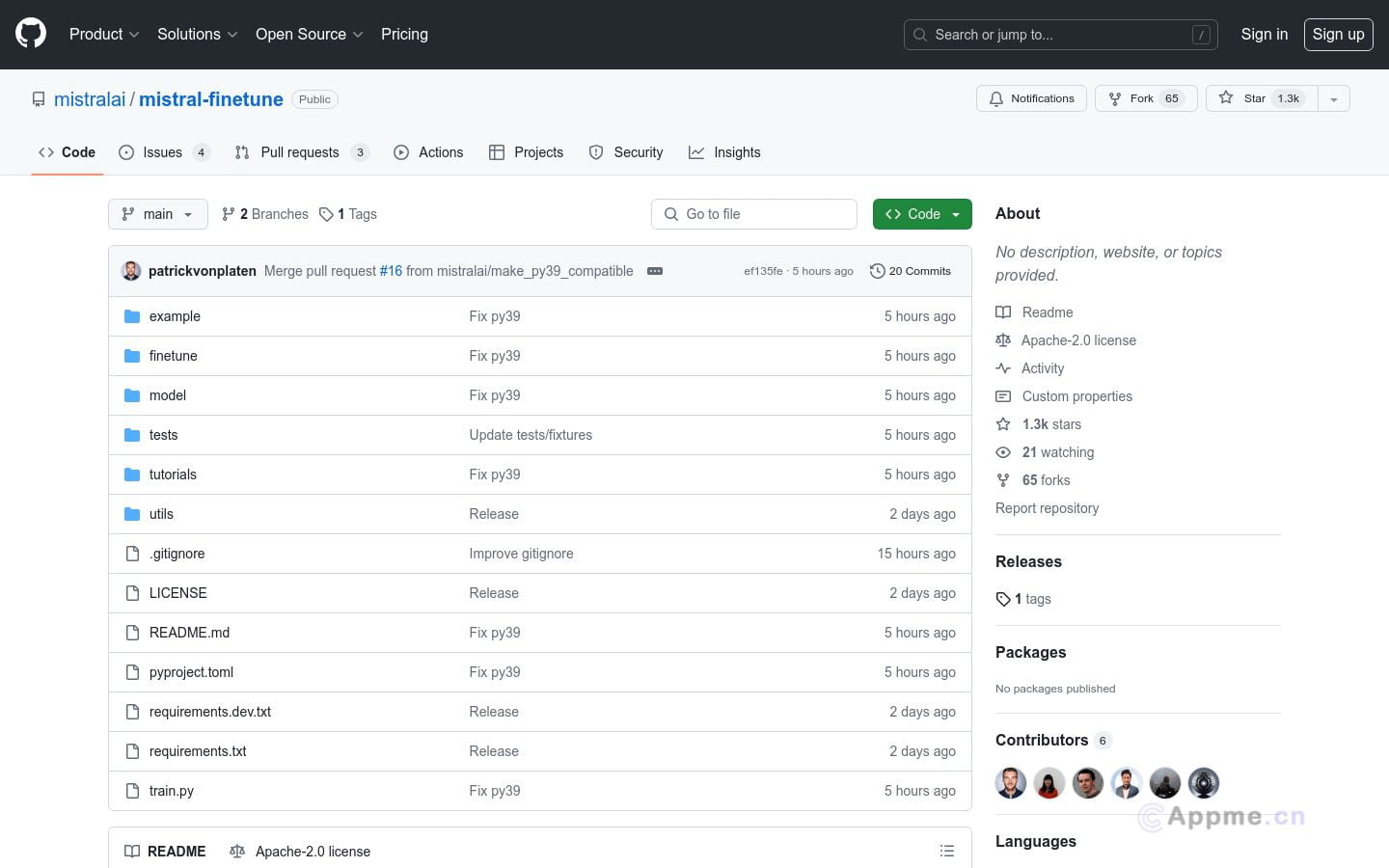

mistral-finetune是一个轻量级的代码库,它基于LoRA训练范式,允许在冻结大部分权重的情况下,只训练1-2%的额外权重,以低秩矩阵微扰的形式进行微调。它被优化用于多GPU单节点训练设置,对于较小模型,例如7B模型,单个GPU就足够了。该代码库旨在提供简单、有指导意义的微调入口,特别是在数据格式化方面,并不旨在涵盖多种模型架构或硬件类型。

需求人群: "目标受众为需要对大型语言模型进行微调的研究人员和开发人员。该产品适合他们,因为它提供了一个轻量级、高效的微调解决方案,尤其适用于资源有限或需要特定功能定制的场景。" 使用场景示例: 研究人员使用mistral-finetune微调7B模型,以适应特定的对话系统。开发人员利用该库为聊天机器人添加新功能,通过微调模型来理解用户查询。教育机构使用mistral-finetune对学生提交的论文进行自动评分,提高评分效率。 产品特色: 支持基于LoRA的训练范式,只训练模型中的一小部分权重。推荐使用A100或H100 GPU以获得最大效率。代码库优化了多GPU单节点训练配置。提供了详细的安装和使用指南,包括依赖安装、模型下载、数据准备等。严格的训练数据格式要求,支持jsonl格式数据文件。支持对话数据和指令跟随数据的训练。提供了数据验证和格式化工具,确保数据正确性。 使用教程: 克隆代码库到本地环境。安装所有必需的依赖项。下载并准备所需的Mistral模型。根据指南准备训练数据集,确保数据格式正确。使用提供的工具验证和格式化数据集。修改配置文件,指定模型路径、数据路径和其他训练参数。启动训练过程,监控训练进度和性能。训练完成后,使用mistral-inference进行模型推理测试。 展开 浏览量:13 s1785318098921236 打开站点