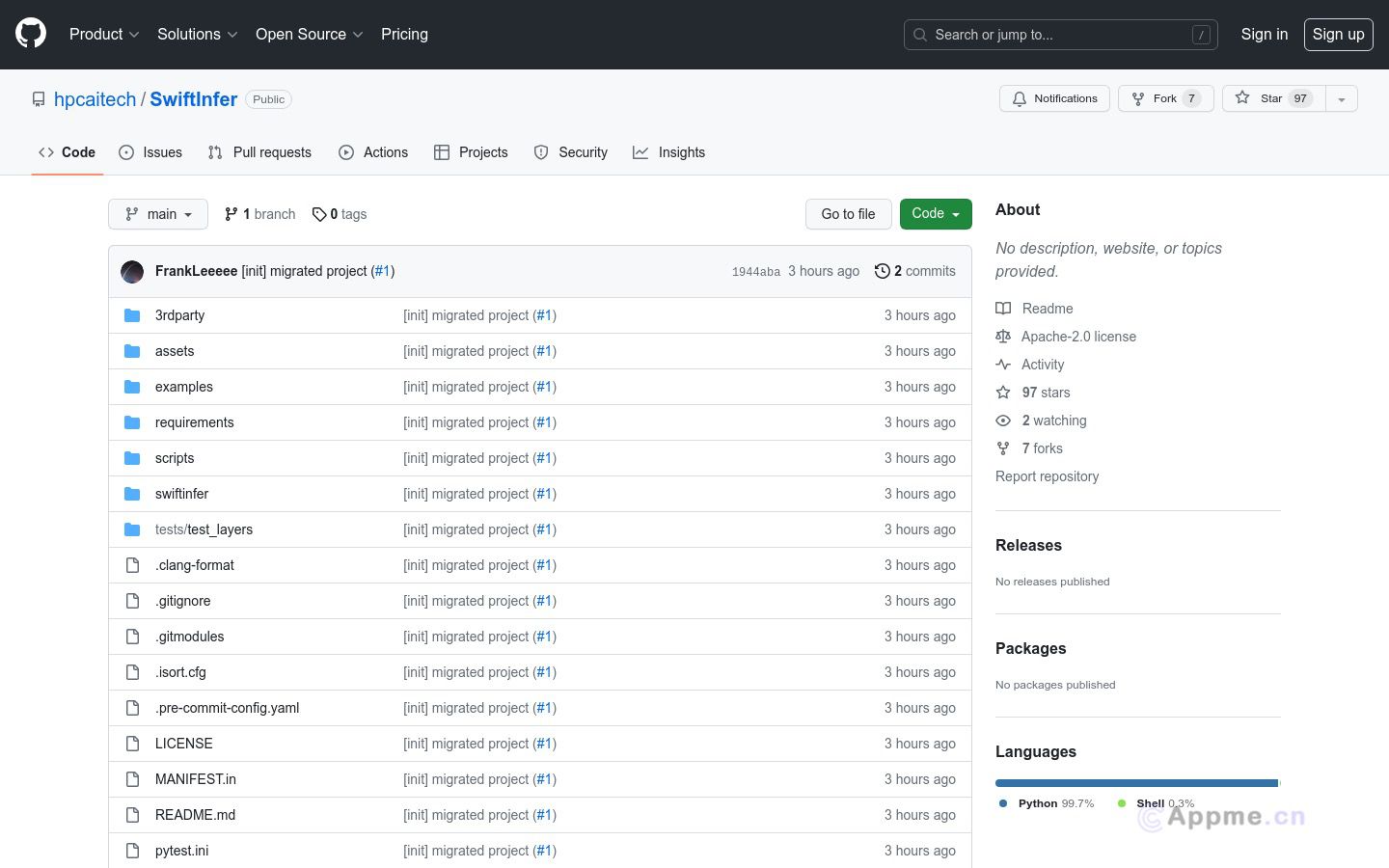

SwiftInfer是一个基于Nvidia TensorRT框架的大规模语言模型(LLM)推理加速库,通过GPU加速,极大提升LLM在生产环境中的推理性能。该项目针对流式语言模型提出的Attention Sink机制进行了实现,支持无限长度的文本生成。代码简洁,运行方便,支持主流的大规模语言模型。

需求人群: "可应用于聊天机器人、长文本生成等需要LLM推理的场景" 使用场景示例: 基于Llama模型的问答聊天机器人自动新闻摘要生成系统根据产品描述自动生成营销文案 产品特色: 支持流式语言模型推理,可处理超长文本GPU加速,推理速度较Pytorch原实现提升3-5倍支持TensorRT部署,方便生产环境集成提供示例代码,能快速上手实际应用