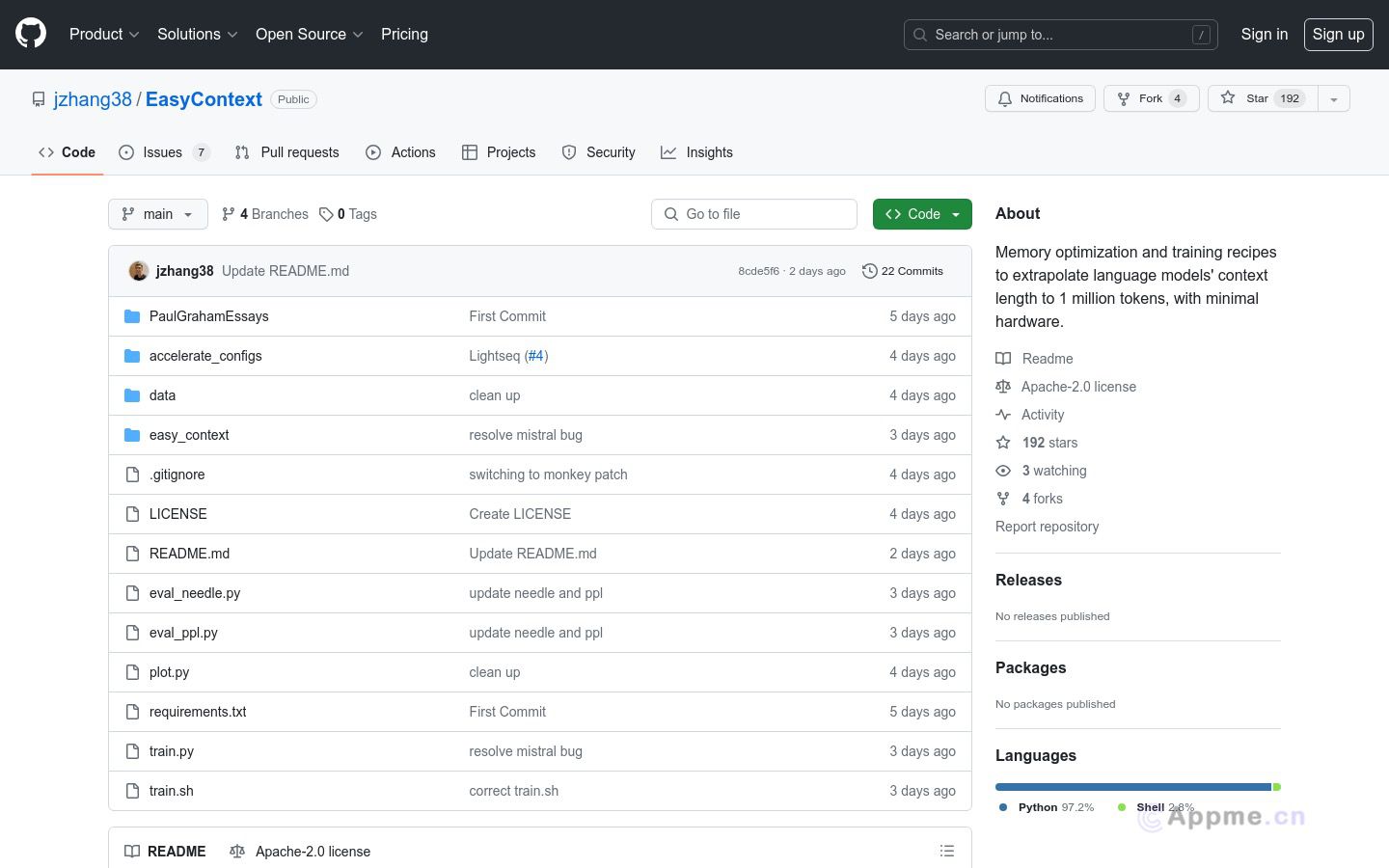

EasyContext是一款开源的语言模型训练工具,旨在实现超长上下文的语言模型训练。它通过结合序列并行、Deepspeed zero3离载、Flash注意力和激活checkpoint等技术,使普通硬件能够训练出具有100万词元上下文长度的模型。EasyContext的主要优势在于它能大幅提升模型的上下文处理能力,为视频生成等应用奠定基础。该工具特别适合研究人员和AI开发者使用,可以帮助他们在有限的硬件资源下训练出具有超长上下文的高性能语言模型。EasyContext已成功应用于Llama-2系列模型的训练,在8块A100上实现了700K词元的上下文长度,在16块A100上达到了1M词元,为用户提供了一种经济高效的方式来突破语言模型的上下文限制,从而推动自然语言处理技术的进步。