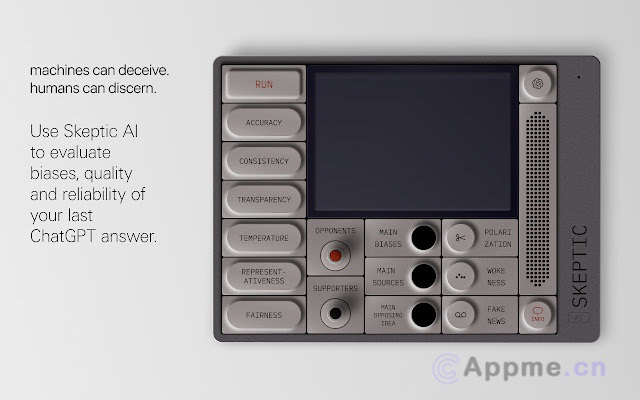

AI评估

AI评估工具是一类专门用于评估和分析人工智能系统性能的软件和平台。这些工具可以全面测试AI模型的准确性、效率、鲁棒性和公平性等多个维度,为AI开发者和研究人员提供宝贵的反馈和洞察。

常见的AI评估工具包括模型评估框架、数据集偏差检测器和性能基准测试套件。其中,MLflow和TensorBoard等开源平台在机器学习实验跟踪和可视化方面表现出色。此外,AI Fairness 360等工具专注于评估AI系统的公平性和道德性。

这类工具的核心优势在于能够提供标准化、可复现的评估流程,帮助开发者优化AI模型并确保其在实际应用中的可靠性。随着AI技术的快速发展,评估工具也在不断演进,未来将更加注重跨领域、跨模态的综合评估能力,为AI系统的可解释性和可信赖性保驾护航。