扩散模型

扩散模型是一类强大的生成式AI工具,主要用于图像、音频和视频的创作与编辑。这类模型通过逐步去噪的过程,能够从随机噪声中生成高质量、多样化的内容。其核心优势在于生成结果的逼真度和可控性,广泛应用于艺术创作、内容制作、虚拟现实等领域。

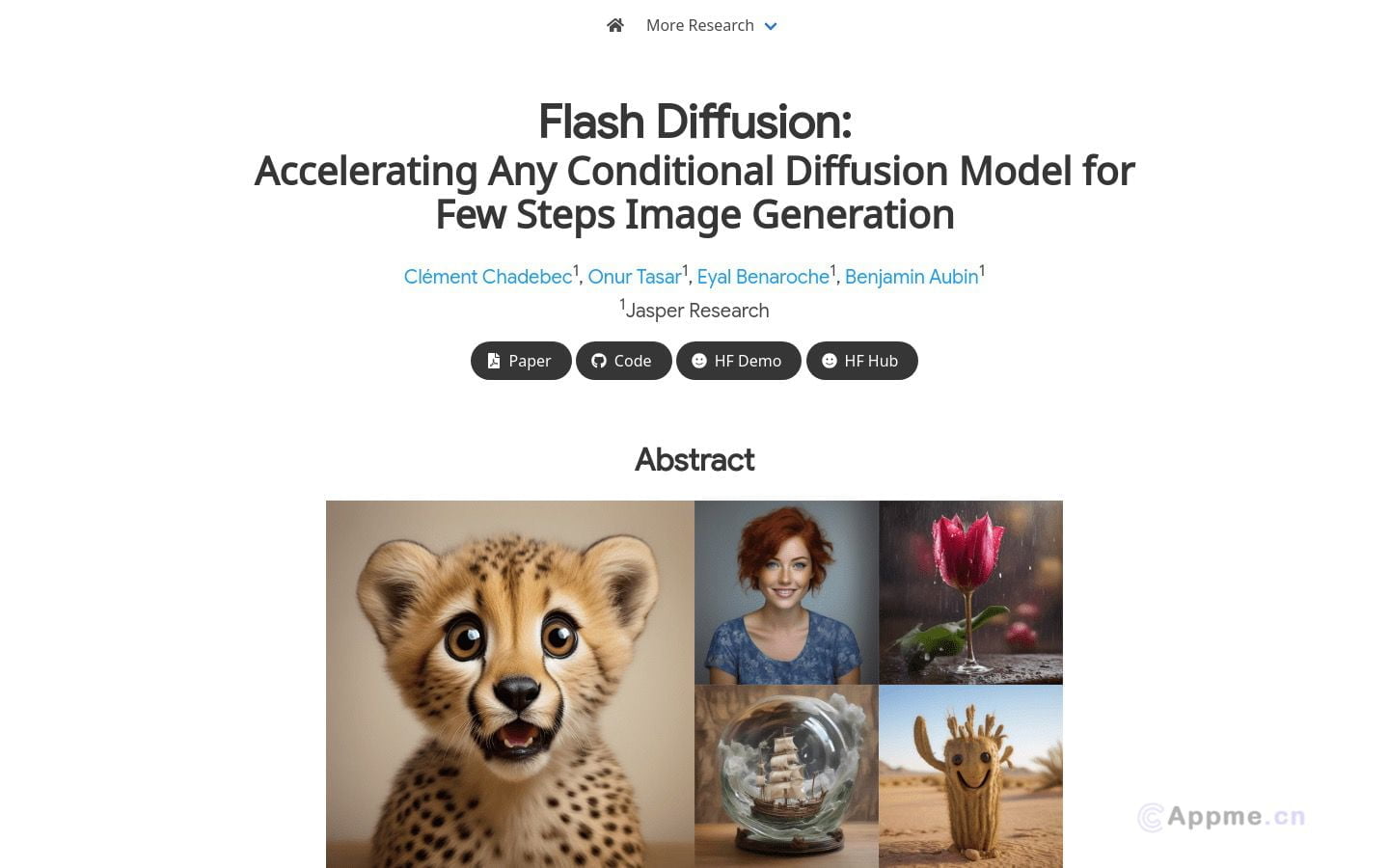

代表性工具包括Stable Diffusion和Midjourney,它们在文本到图像生成方面表现出色。此外,扩散模型还可用于图像修复、超分辨率重建等任务。

扩散模型采用深度学习技术,结合了U-Net架构和注意力机制,能够捕捉复杂的数据分布。随着模型规模和训练数据的增加,生成质量不断提升,逐渐接近真实世界的复杂度。

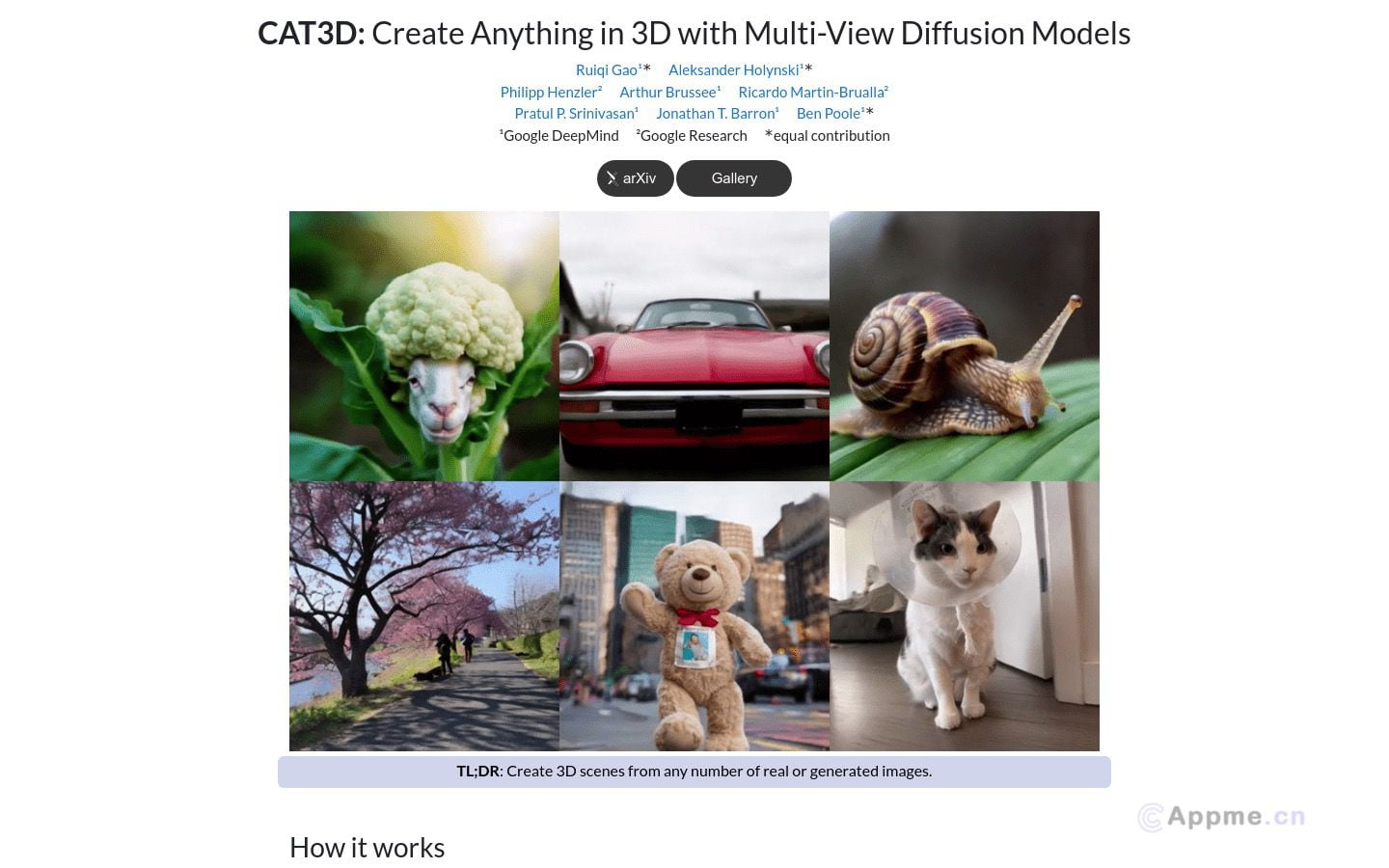

未来,扩散模型有望在3D内容生成、跨模态转换等方向取得突破,为创意产业带来革命性变革。随着技术的进步,我们可以期待更快速、更精确、更个性化的AI创作工具的出现。