扩散模型

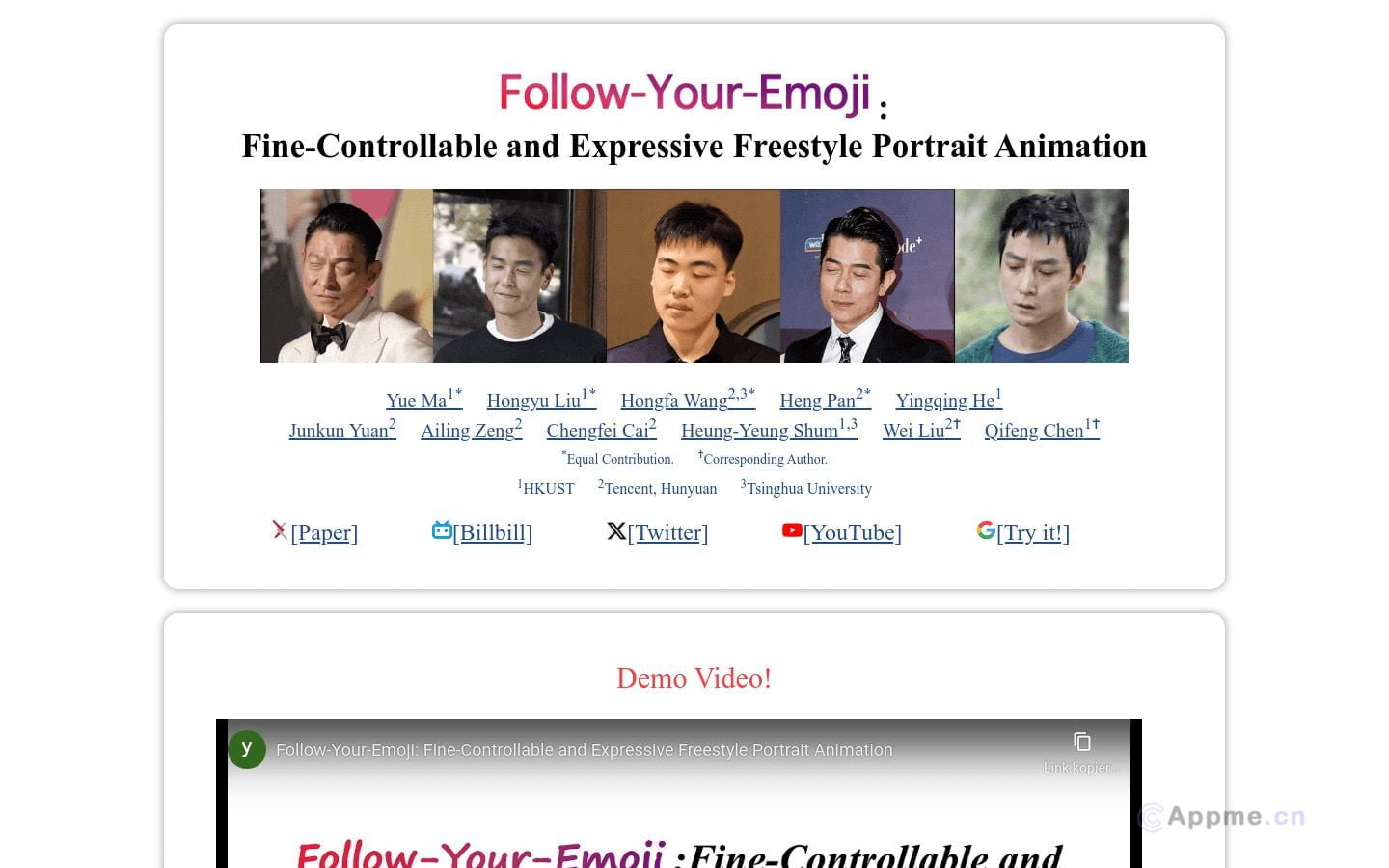

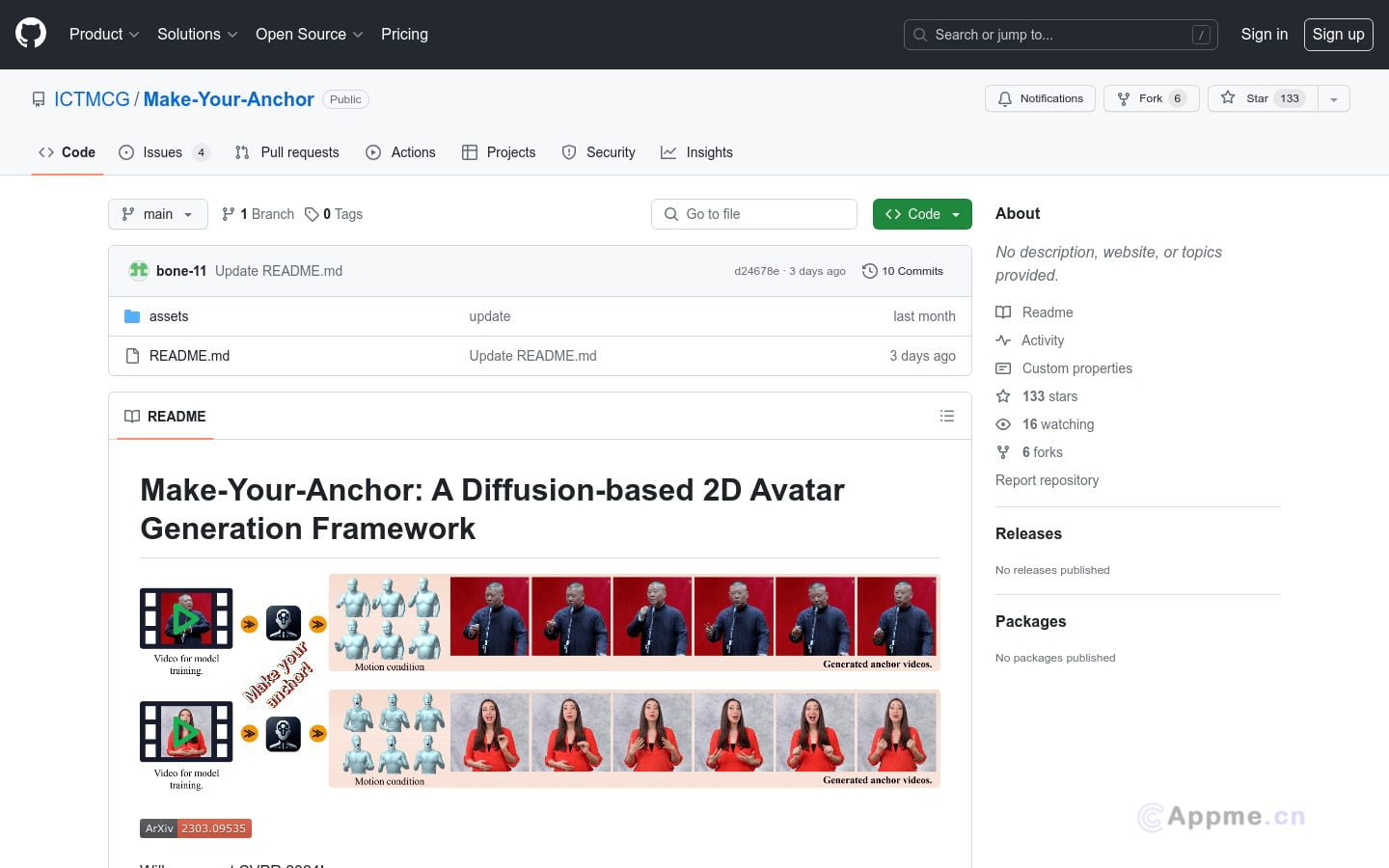

Ai模型最新工具Make-Your-Anchor,Make-Your-Anchor是一个基于扩散模型的2D虚拟形象生成框架。它只需一段1分钟左右的视频素材就可以自动生成具有精确上身和手部动作的主播风格视频。该系统采用了一种结构引导的扩散模型来将3D网格状态渲染成人物外观。通过两阶段训练策略,有效地将运动与特定外观相绑定。为了生成任意长度的时序视频,将frame-wise扩散模型的2D U-Net扩展到3D形式,并提出简单有效的批重叠时序去噪模块,从而突破推理时的视频长度限制。最后,引入了一种基于特定身份的面部增强模块,提高输出视频中面部区域的视觉质量。实验表明,该系统在视觉质量、时序一致性和身份保真度方面均优于现有技术。

扩散模型是一类强大的生成式AI工具,主要用于图像、音频和视频的创作与编辑。这类模型通过逐步去噪的过程,能够从随机噪声中生成高质量、多样化的内容。其核心优势在于生成结果的逼真度和可控性,广泛应用于艺术创作、内容制作、虚拟现实等领域。

代表性工具包括Stable Diffusion和Midjourney,它们在文本到图像生成方面表现出色。此外,扩散模型还可用于图像修复、超分辨率重建等任务。

扩散模型采用深度学习技术,结合了U-Net架构和注意力机制,能够捕捉复杂的数据分布。随着模型规模和训练数据的增加,生成质量不断提升,逐渐接近真实世界的复杂度。

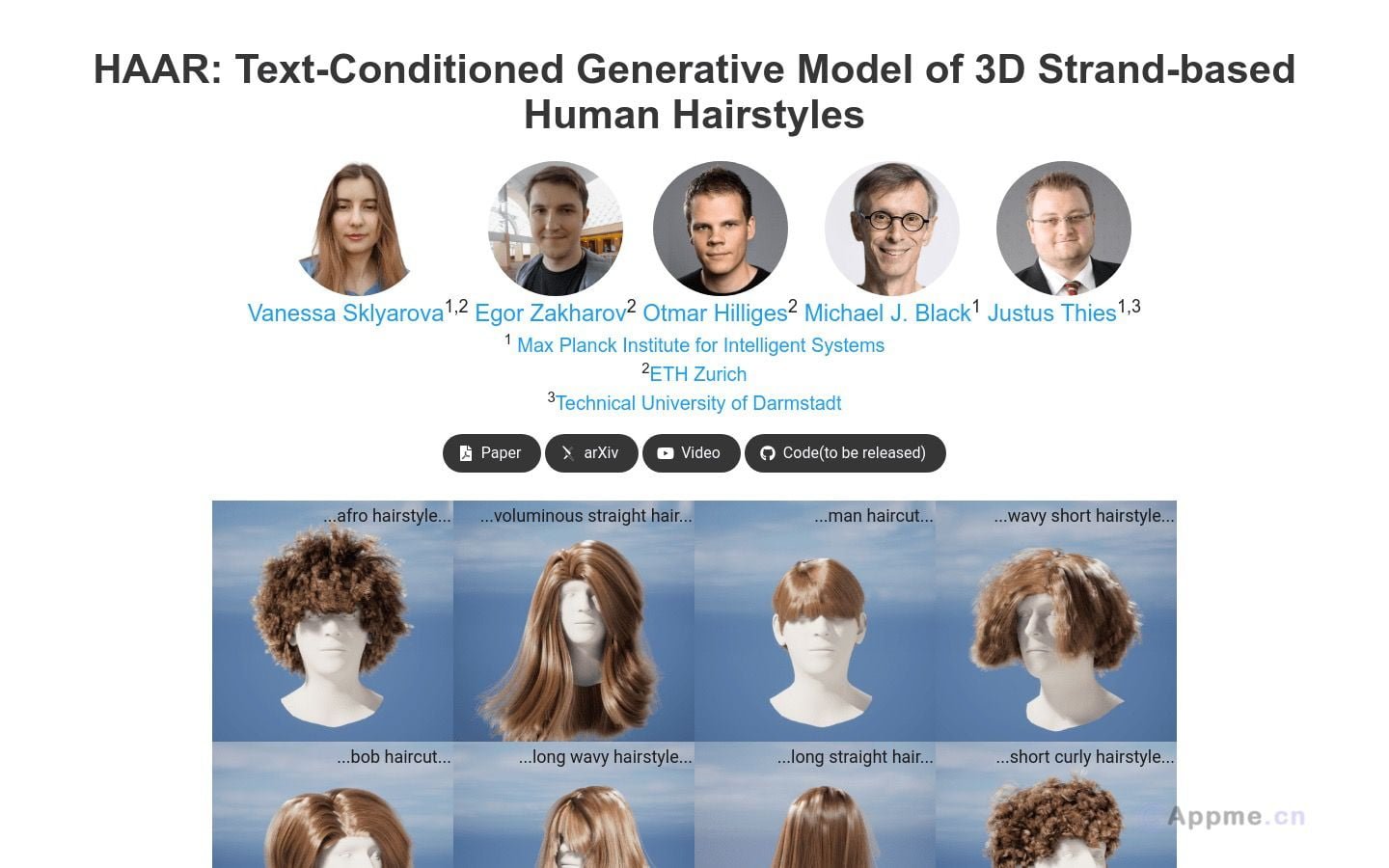

未来,扩散模型有望在3D内容生成、跨模态转换等方向取得突破,为创意产业带来革命性变革。随着技术的进步,我们可以期待更快速、更精确、更个性化的AI创作工具的出现。