语言模型

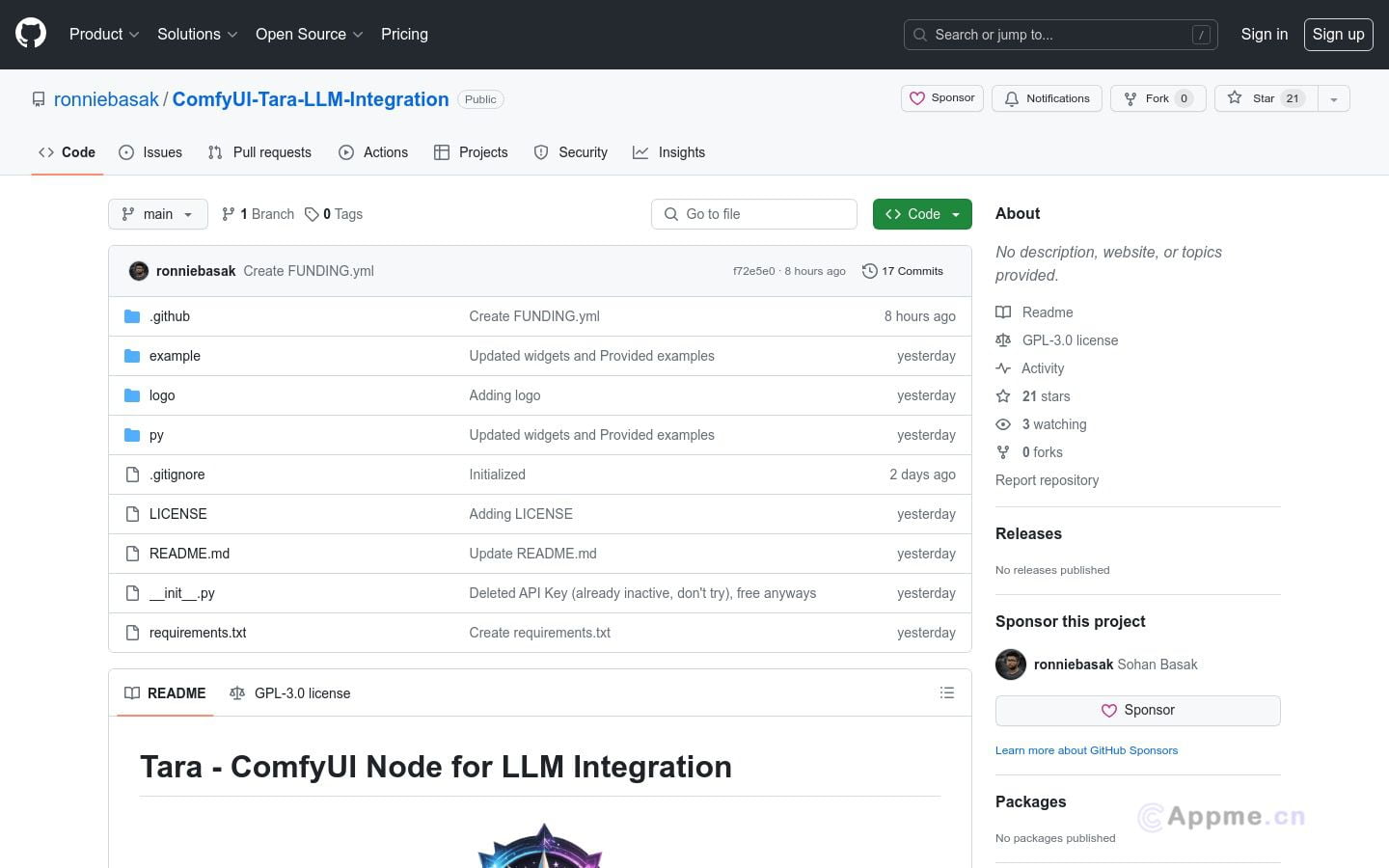

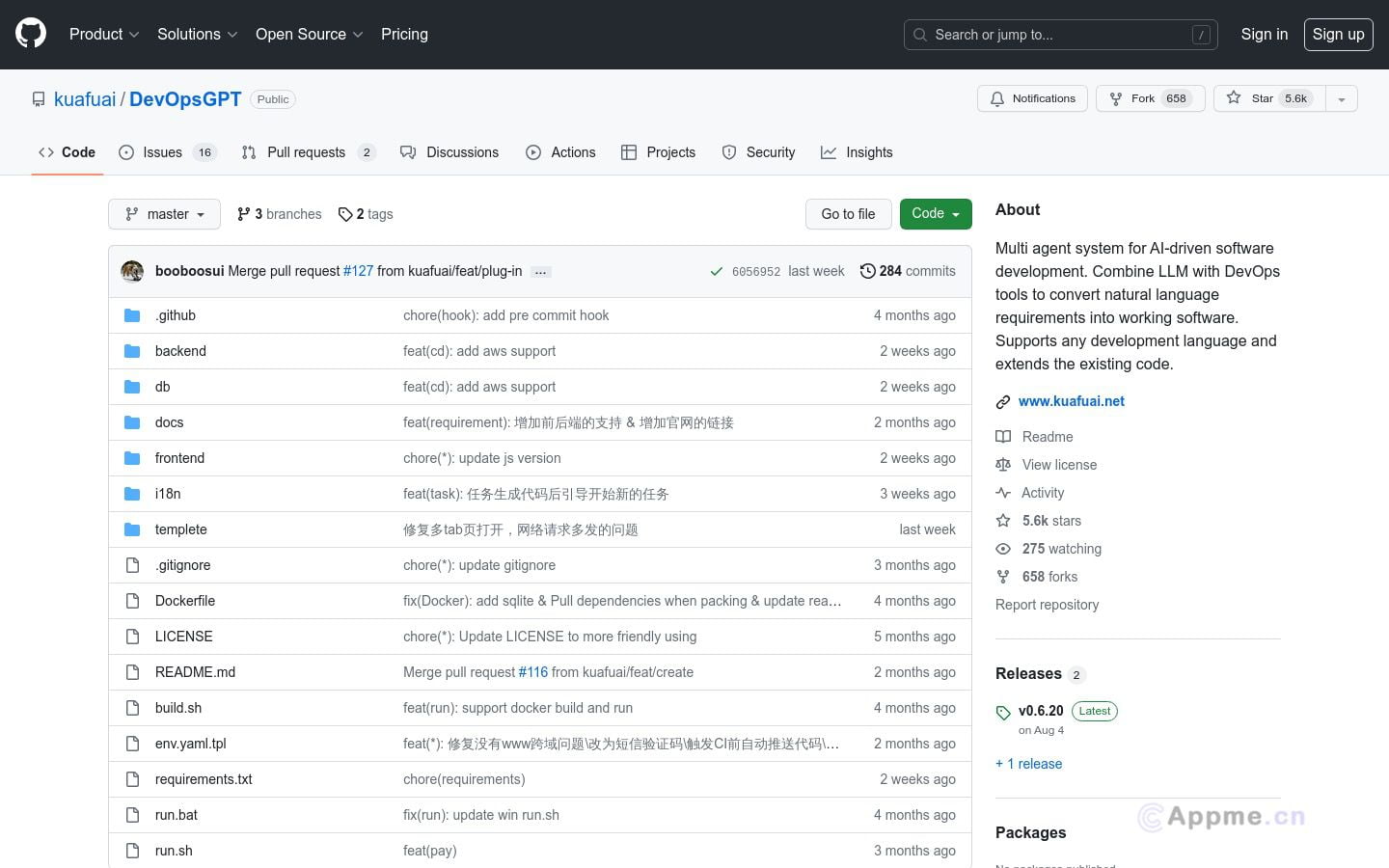

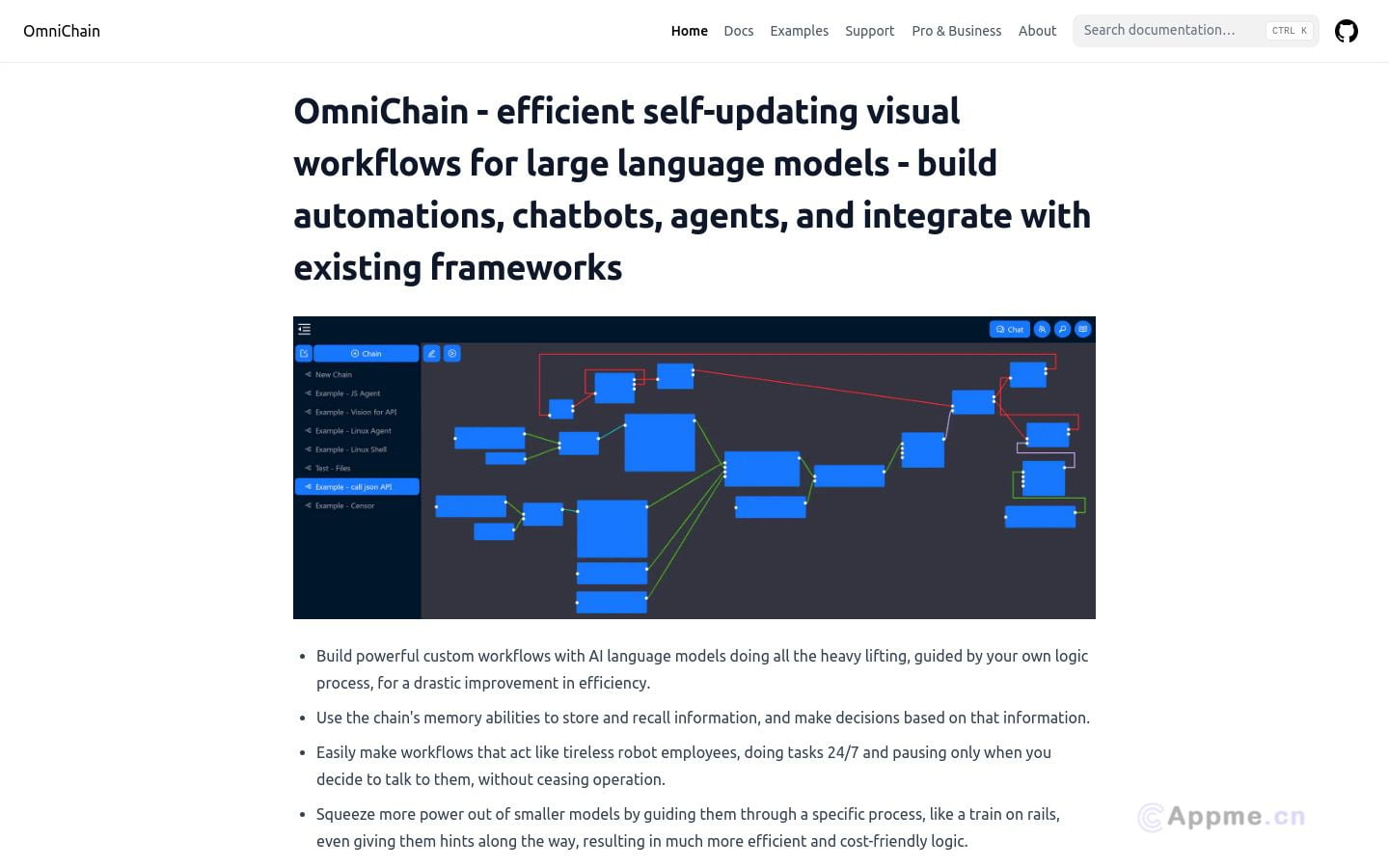

语言模型是人工智能领域的核心技术之一,主要用于自然语言处理和生成任务。这类AI工具能够理解和生成人类语言,广泛应用于机器翻译、智能问答、文本摘要、对话系统等场景。其核心优势在于强大的语言理解和生成能力,可以处理多种语言和各类文本数据。

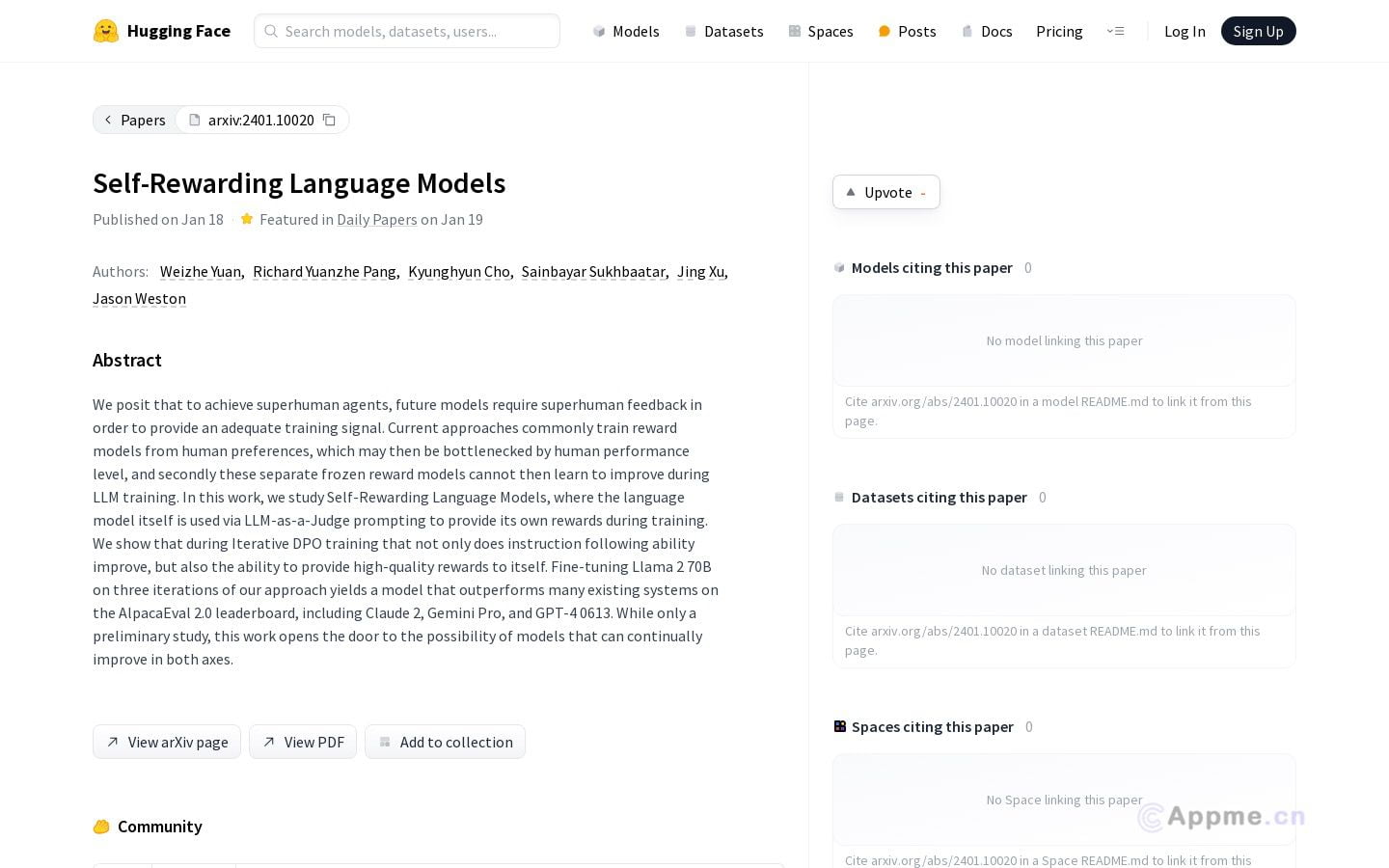

GPT(生成式预训练转换器)和BERT(双向编码器表示转换器)是该领域的代表性技术。这些大规模预训练模型通过自监督学习,可以捕捉语言的深层语义和上下文信息。

近年来,语言模型在参数规模、训练数据量和算法设计等方面不断突破,性能持续提升。它们在多模态融合、跨语言理解、常识推理等方面展现出巨大潜力,有望推动人工智能向更高级的认知智能发展。

未来,语言模型将在提升可解释性、降低计算成本、增强领域适应性等方面继续演进,为各行各业带来更多创新应用。