LoRA

LoRA (Low-Rank Adaptation) 是一种高效的微调方法,主要应用于大型语言模型和扩散模型的定制化训练。它通过添加少量可训练参数来适应特定任务,显著降低了计算资源需求和训练时间。

LoRA 的核心优势在于其高效性和灵活性。它能在保持模型性能的同时,大幅减少微调所需的显存和计算量,使得在消费级硬件上训练大型模型成为可能。这种方法特别适用于个性化应用、领域适应和多任务学习场景。

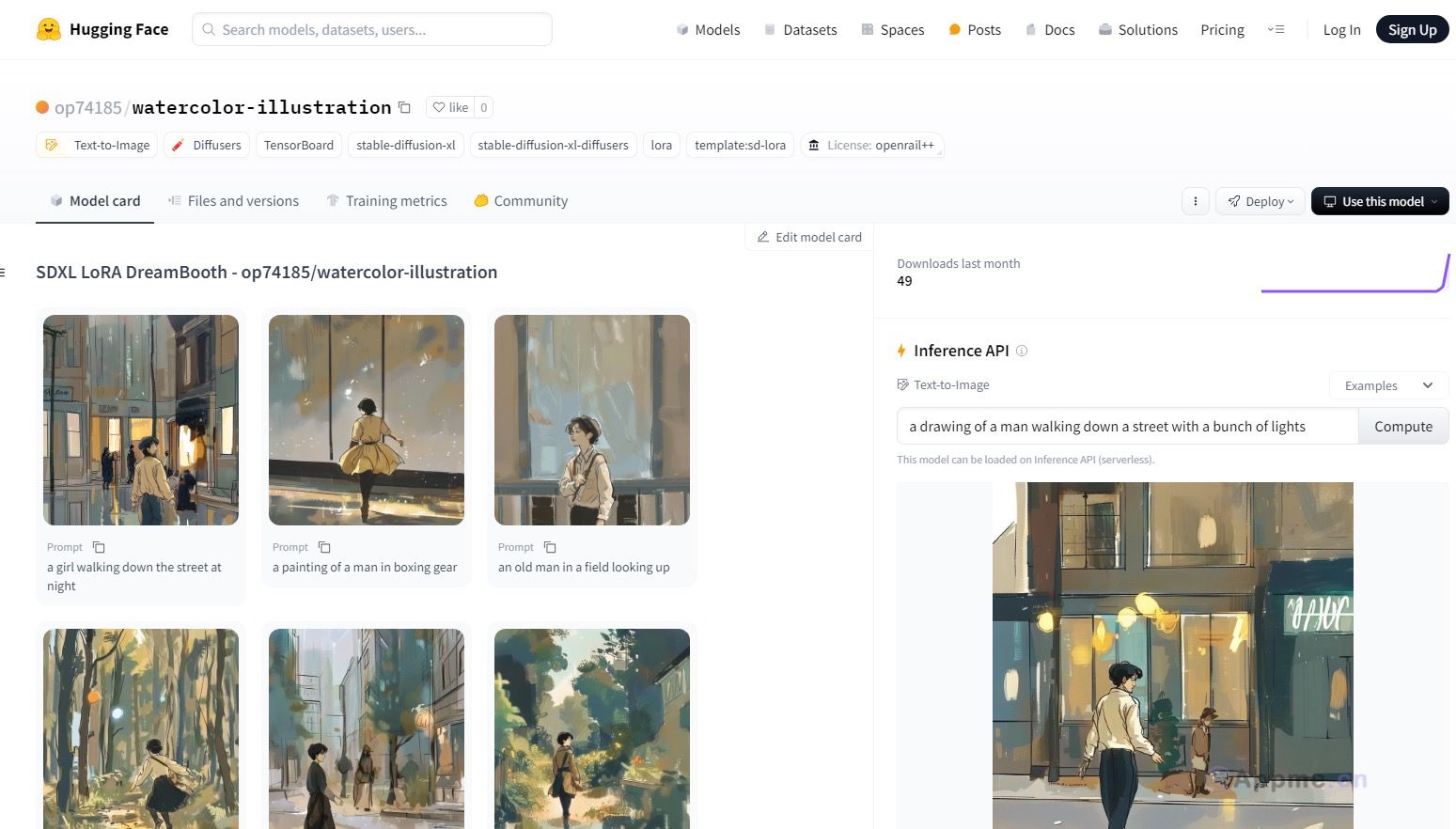

代表性工具包括 HuggingFace 的 PEFT 库和 Microsoft 的 LoRA 实现。此外,Stable Diffusion WebUI 等开源项目也广泛集成了 LoRA 技术,使其在图像生成领域得到广泛应用。

随着模型规模的不断增长,LoRA 在提高模型适应性和降低部署成本方面的重要性将进一步凸显。未来,我们可能会看到更多基于 LoRA 的创新应用和优化技术的出现。

bilibot

想体验AI聊天的魅力吗?bilibot让你免费畅聊!这款基于哔哩哔哩用户评论训练的本地聊天机器人,支持文字和语音对话,反应迅速自然。搭载32B参数的强大模型,结合LORA微调,对话质量媲美GPT-3.5。还有可爱的派蒙语音,让聊天更有趣!快来试试这款智能又有趣的AI助手吧!