多模态学习

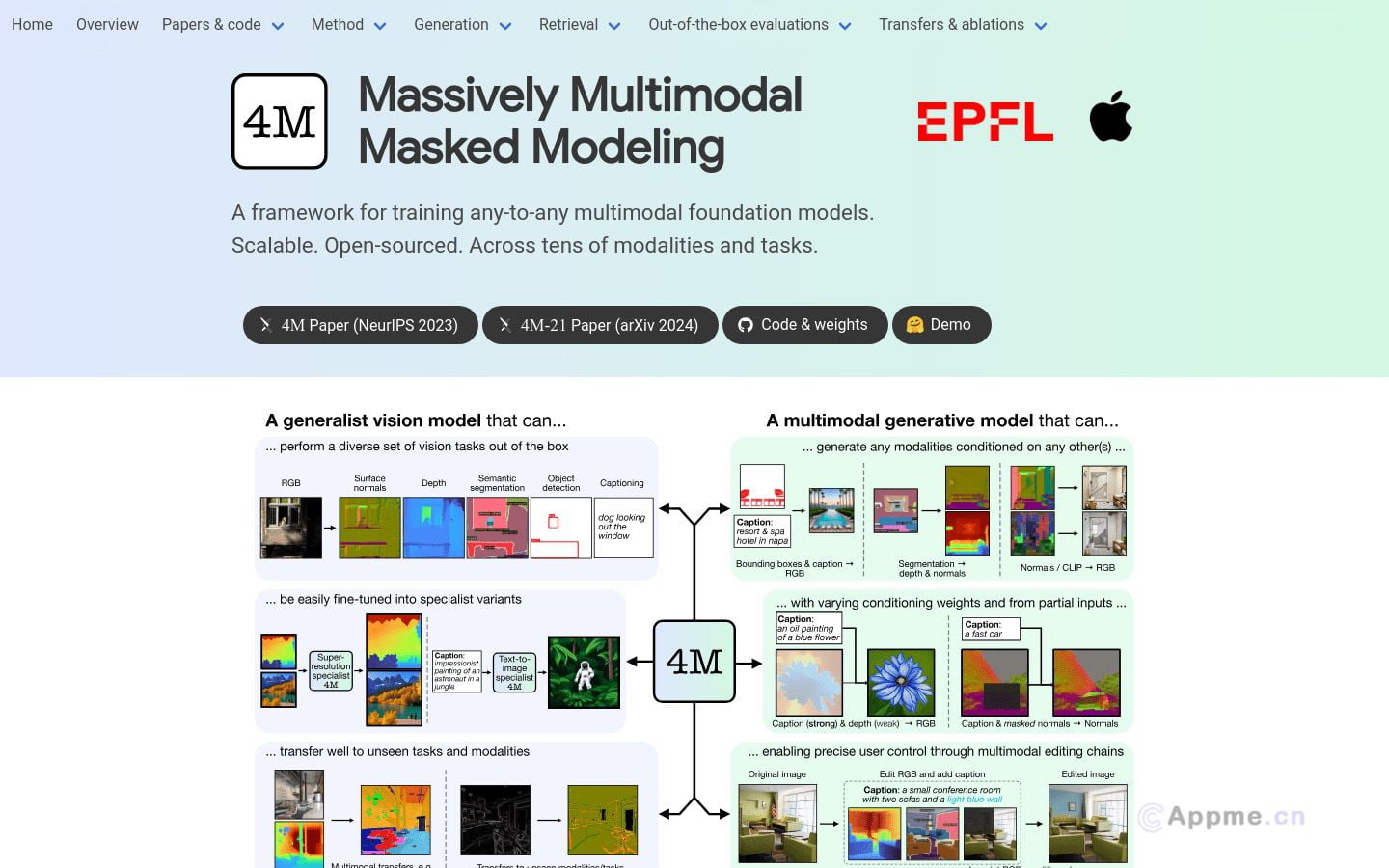

多模态学习是人工智能领域的前沿方向,致力于整合视觉、语言、声音等多种模态信息,实现跨模态理解与生成。这类AI工具能够同时处理图像、文本、语音等多种数据类型,在图像识别、自然语言处理、语音合成等任务中表现出色。

代表性技术包括OpenAI的CLIP(Contrastive Language-Image Pre-training)和Google的DALL-E,它们能够实现文本到图像的生成,以及图像到文本的描述。这些工具在内容创作、智能搜索、辅助诊断等领域有广泛应用。

多模态学习模型通常采用深度神经网络架构,如Transformer和GAN,具有强大的特征提取和跨模态映射能力。它们能够捕捉不同模态间的语义关联,实现更全面、准确的场景理解。

随着大规模预训练模型和自监督学习技术的发展,多模态AI工具正朝着更强大、通用的方向演进,有望在人机交互、元宇宙等新兴领域发挥重要作用。