视觉模型

视觉模型是一类专门处理和理解图像、视频等视觉数据的人工智能系统。它们能够执行图像分类、目标检测、语义分割等多种视觉任务,广泛应用于计算机视觉、图像处理、机器人视觉等领域。这类模型的核心优势在于其强大的特征提取和表示学习能力,可以从复杂的视觉场景中捕捉关键信息。

代表性技术包括卷积神经网络(CNN)和视觉Transformer(ViT)。前者善于提取局部特征,后者则擅长建模长程依赖关系。目前业界广泛使用的有YOLO系列和Mask R-CNN等。

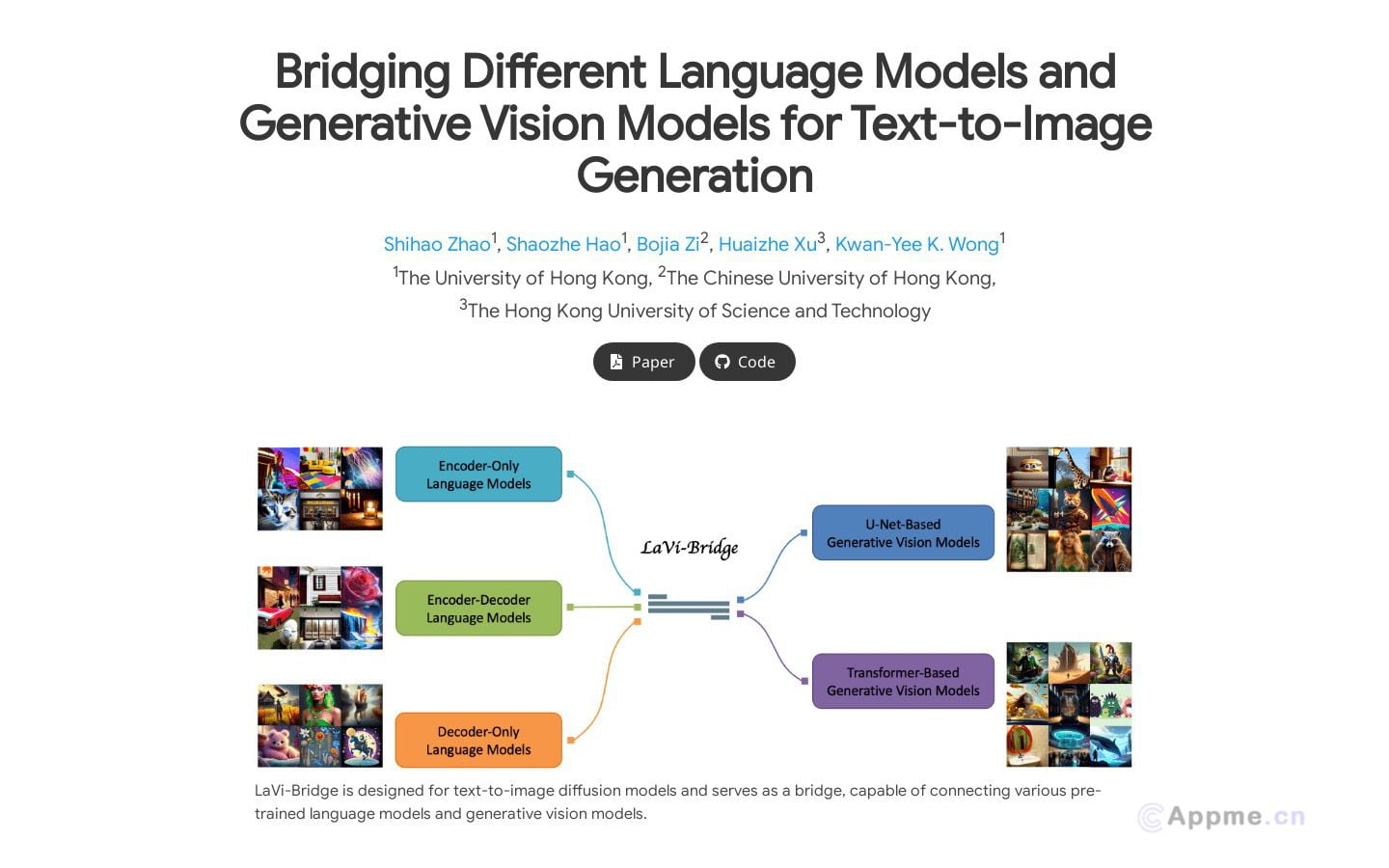

视觉模型在医疗影像分析、自动驾驶、安防监控等领域发挥着重要作用。随着多模态学习的发展,视觉模型正与自然语言处理等技术深度融合,朝着更智能、更通用的方向演进。未来,视觉模型有望在虚拟现实、增强现实等新兴领域带来更多突破性应用。