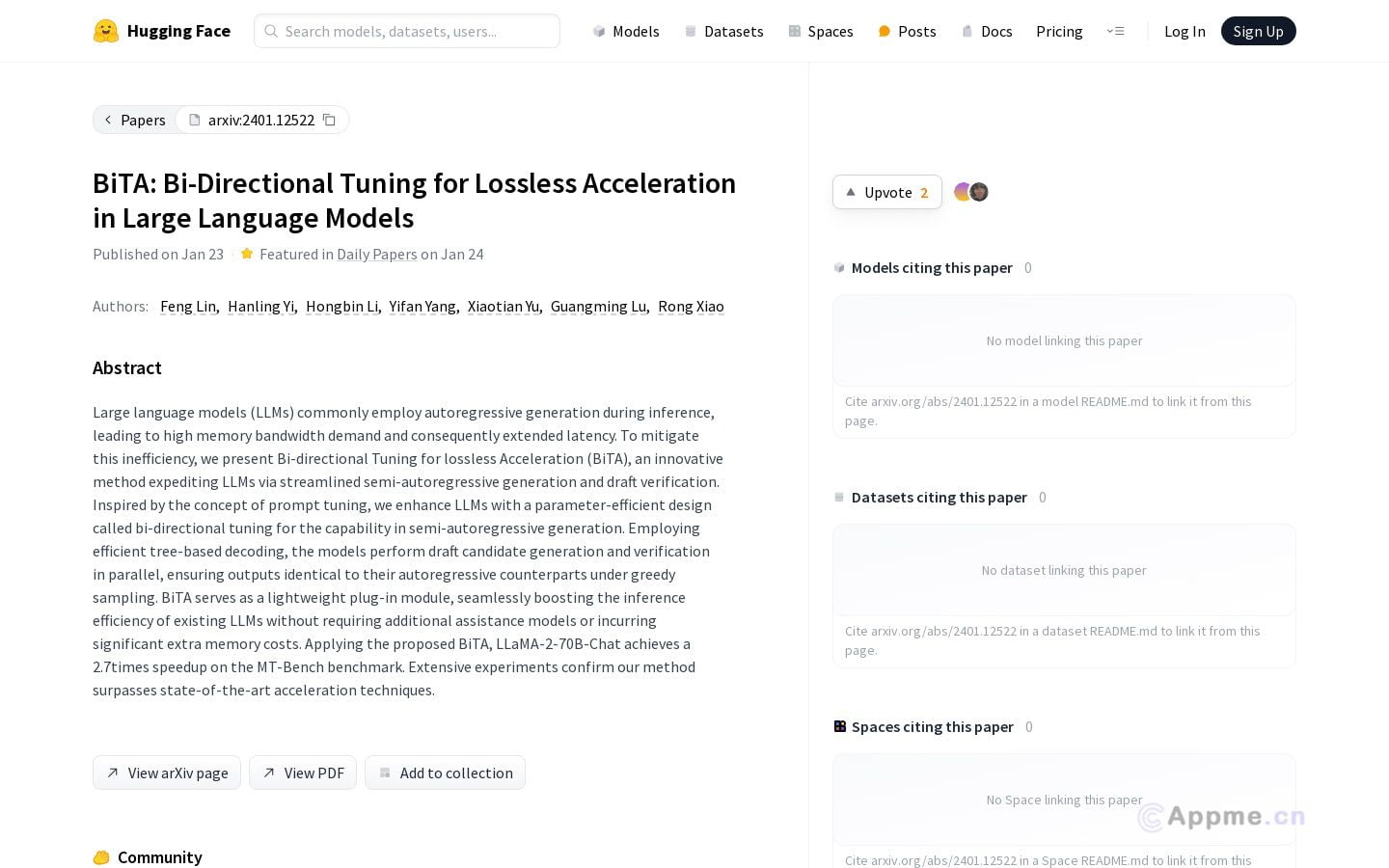

BiTA是一款创新的AI插件工具,专为提升大型语言模型的推断效率而设计。作为轻量级插件模块,BiTA通过双向调节方法和简化的半自回归生成技术,显著加速大型语言模型的运行速度。它无需额外的辅助模型,也不会产生显著的额外内存开销,可以无缝集成到现有的大型语言模型中。在实际应用中,BiTA已在MT-Bench基准测试上将LLaMA-2-70B-Chat的速度提升了2.7倍,超越了当前最先进的加速技术。

这款工具特别适合需要在网站、小程序或桌面客户端中应用大型语言模型,并追求高效推断的开发者和企业。通过使用BiTA,用户可以显著提高语言模型的响应速度,优化用户体验,同时降低计算资源消耗,为AI应用带来更高的性能和更低的运营成本。