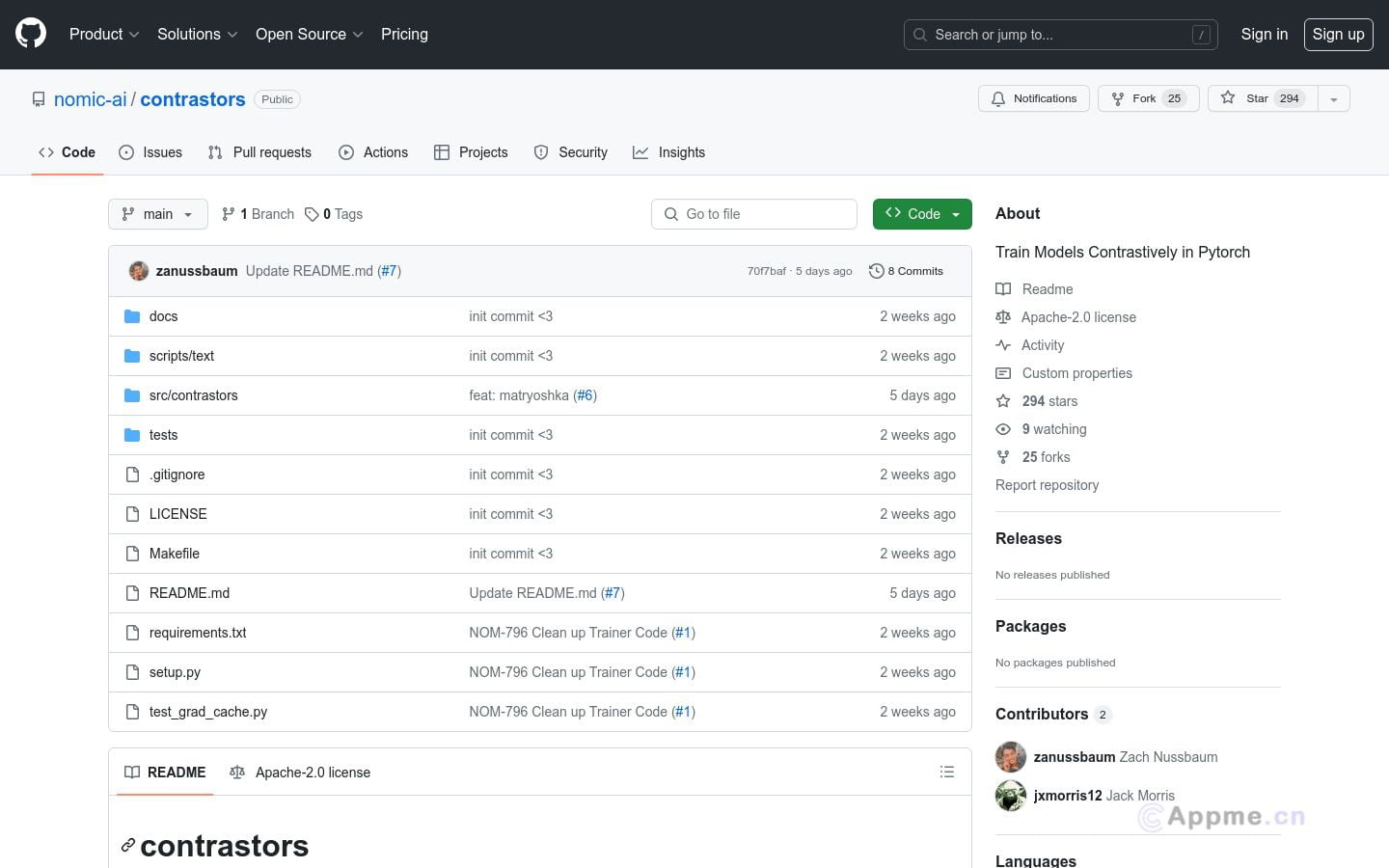

contrastors是一款功能强大的对比学习工具包,专为研究人员和工程师设计,旨在高效训练和评估对比模型。它基于Flash Attention构建,支持多GPU训练和GradCache,能在有限内存条件下进行大批量训练。该工具兼容Huggingface,可轻松加载常见模型,同时支持遮蔽语言建模预训练和Matryoshka表示学习。contrastors的多GPU支持和大批量训练能力使其特别适合需要处理大规模数据的研究团队和企业。它为用户提供了从零开始训练BERT模型、微调现有模型以及生成自定义数据集等多种应用场景。通过contrastors,用户可以显著提升对比学习模型的训练效率和性能,为自然语言处理和机器学习领域的研究与应用带来巨大价值。