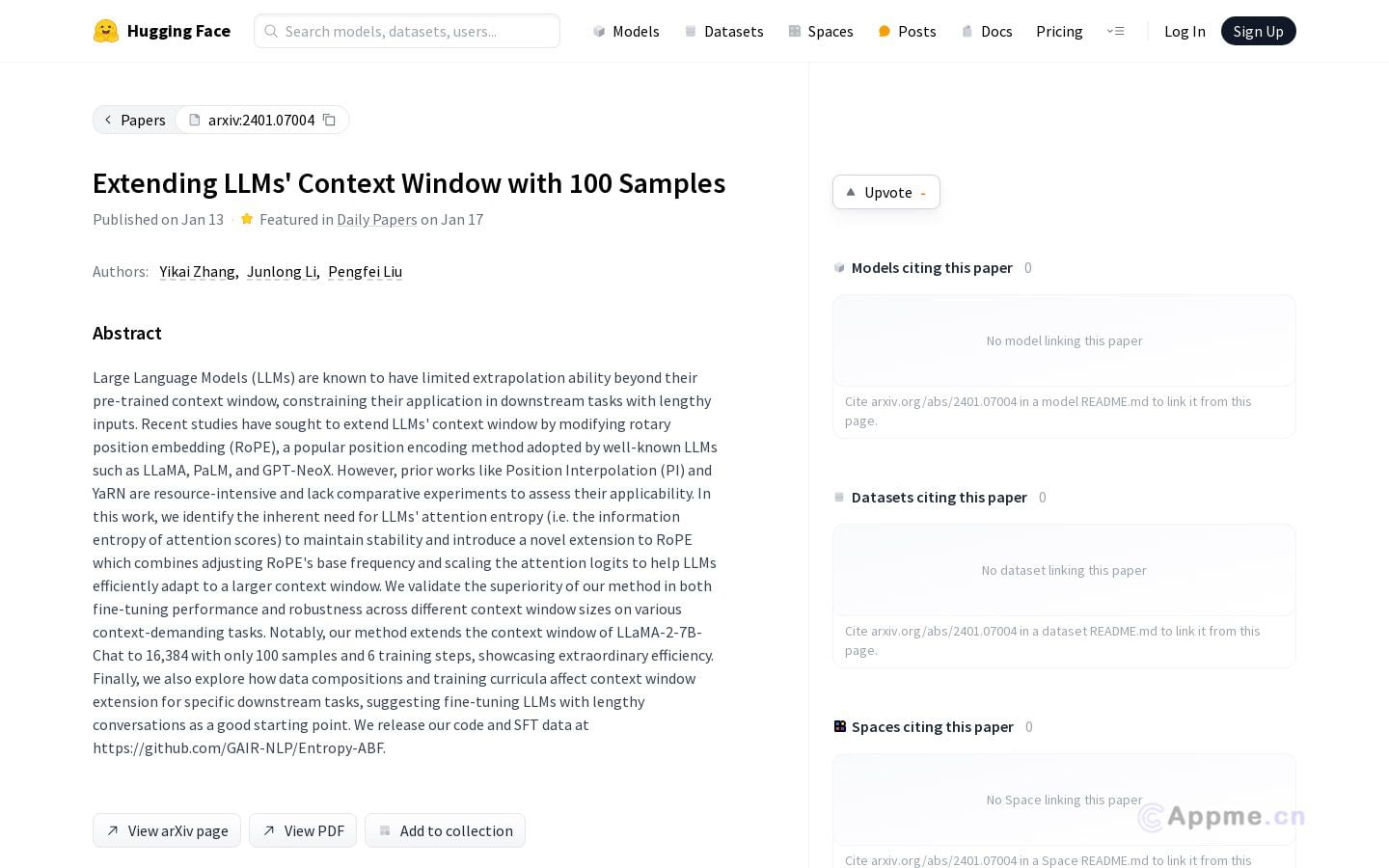

LLM Context Extender是一款专为扩展大型语言模型(LLMs)上下文窗口而设计的强大工具。通过调整RoPE基础频率和缩放注意力logits,它能有效帮助LLMs适应更大的上下文窗口,显著提升模型性能和稳健性。该工具展示了惊人的效率,仅需100个样本和6个训练步骤就能将LLaMA-2-7B-Chat的上下文窗口扩展到16,384。它特别适合NLP研究人员、AI开发者和企业用户,可用于各种需要处理长文本或复杂上下文的场景。LLM Context Extender不仅能优化模型在特定任务中的表现,还为探索数据组成和训练课程对上下文窗口扩展的影响提供了宝贵工具。总之,它为提升LLMs在长对话和复杂任务中的性能开辟了新途径,为AI应用带来更多可能性。