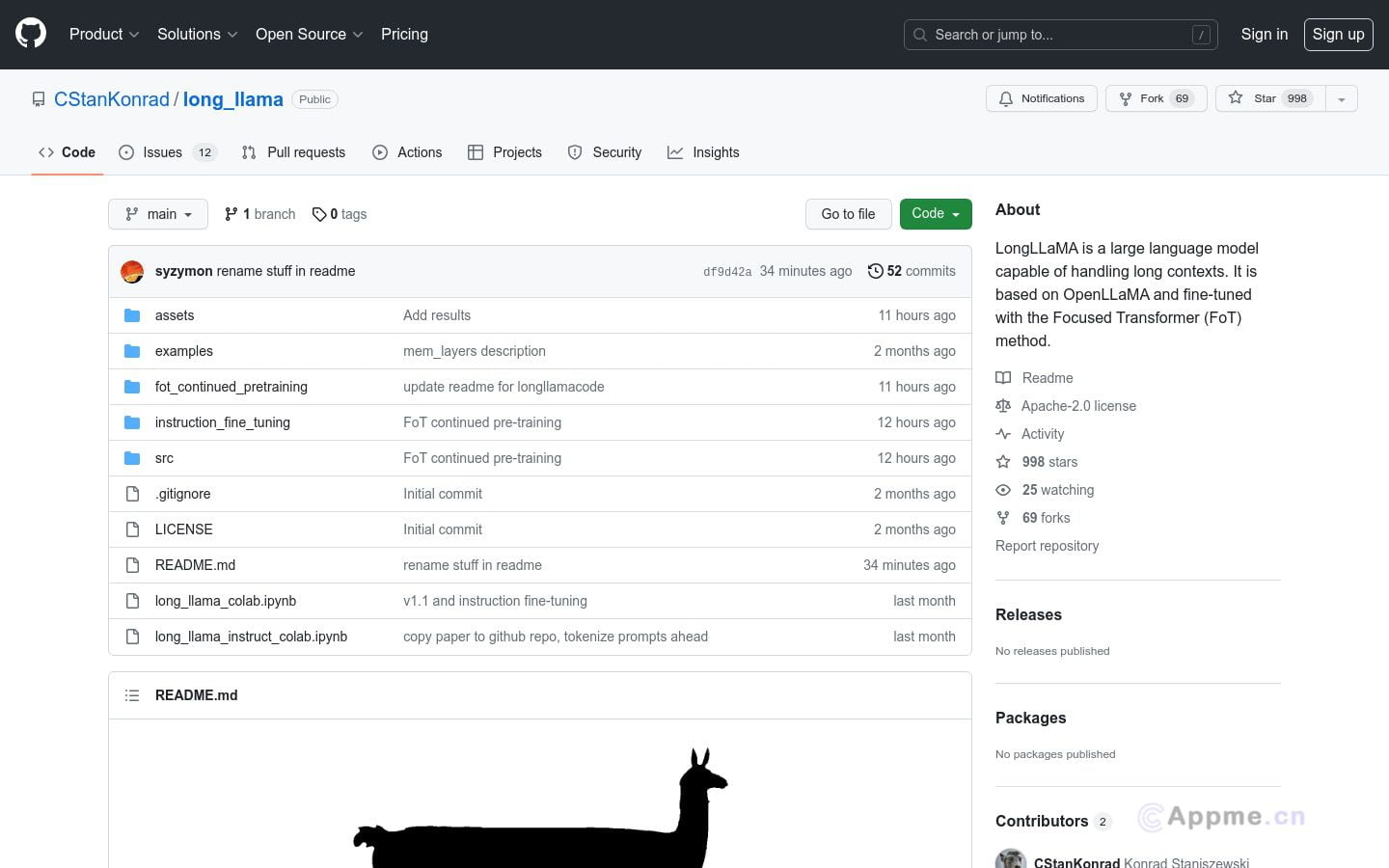

LongLLaMA是一款强大的大型语言模型,专门设计用于处理长篇文本。它基于OpenLLaMA,通过Focused Transformer技术进行微调,能够处理长达256k甚至更多标记的文本,大幅超越了传统模型的2048标记限制。LongLLaMA提供了一个3B参数的基础模型,以及支持长上下文推断的代码。它在保持原有短文本处理能力的同时,显著提升了长文本理解和生成能力。这使得LongLLaMA成为各类自然语言处理任务的理想选择,如长文本生成、文档摘要、复杂问答系统等。对于需要处理大量长篇文本的研究人员、开发者和内容创作者来说,LongLLaMA提供了前所未有的文本处理能力,有助于提高工作效率和输出质量。