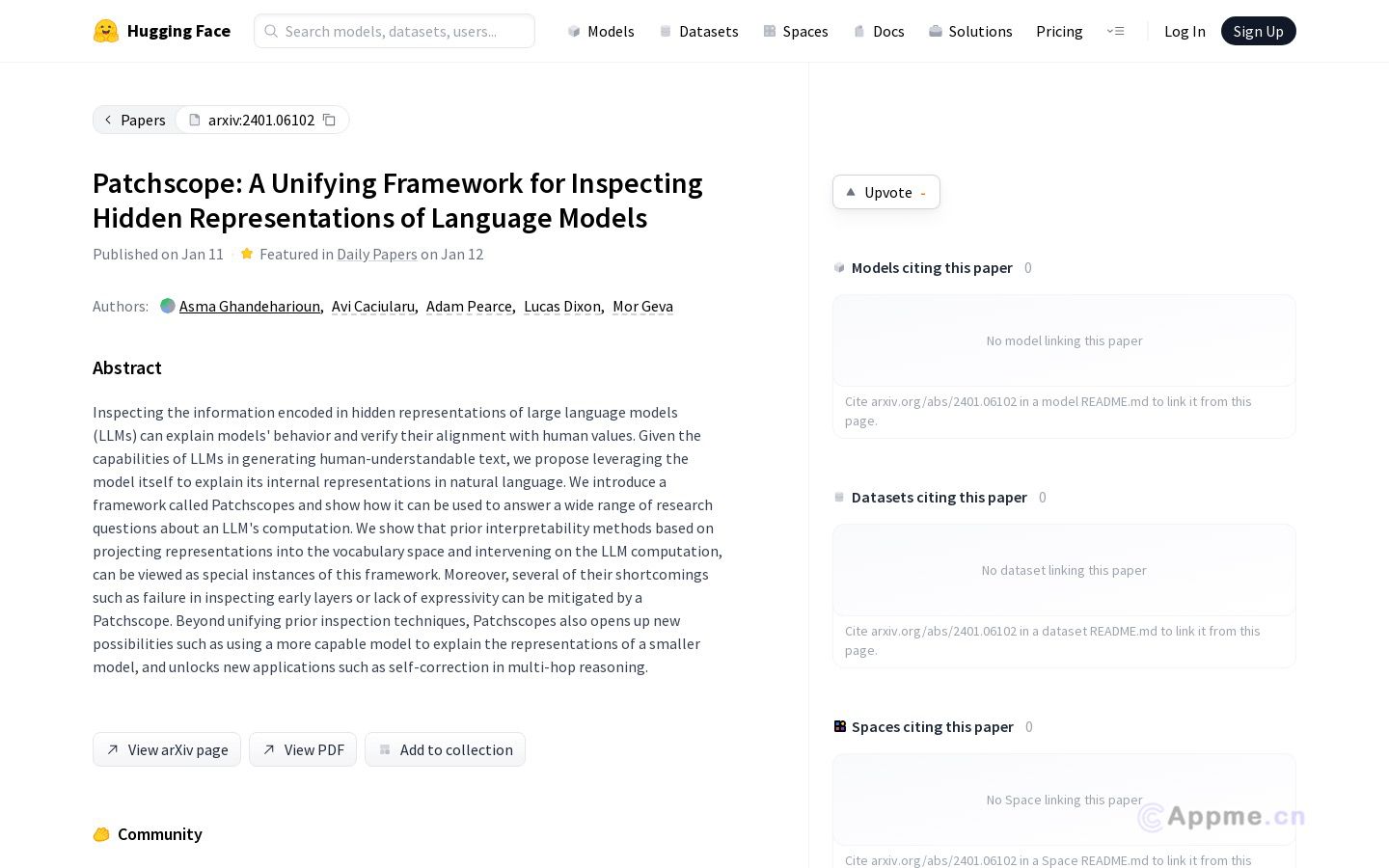

Patchscope是一款专为检查和解释大型语言模型(LLM)内部表示而设计的创新框架。它能够深入分析模型行为,验证其与人类价值观的一致性,并回答关于LLM计算的广泛研究问题。该工具的独特之处在于利用模型自身来解释其内部表示,生成人类可理解的文本。Patchscope不仅涵盖了现有的可解释性方法,还开创了新的应用可能,如使用更强大的模型解释较小模型,以及实现多跳推理等自我纠正功能。这一工具对于AI研究人员、模型开发者和伦理学家尤为有用,能帮助他们深入理解LLM的内部机制,提高模型透明度,并确保AI系统与人类价值观保持一致。Patchscope为探索和改进AI系统提供了强大而灵活的解决方案。