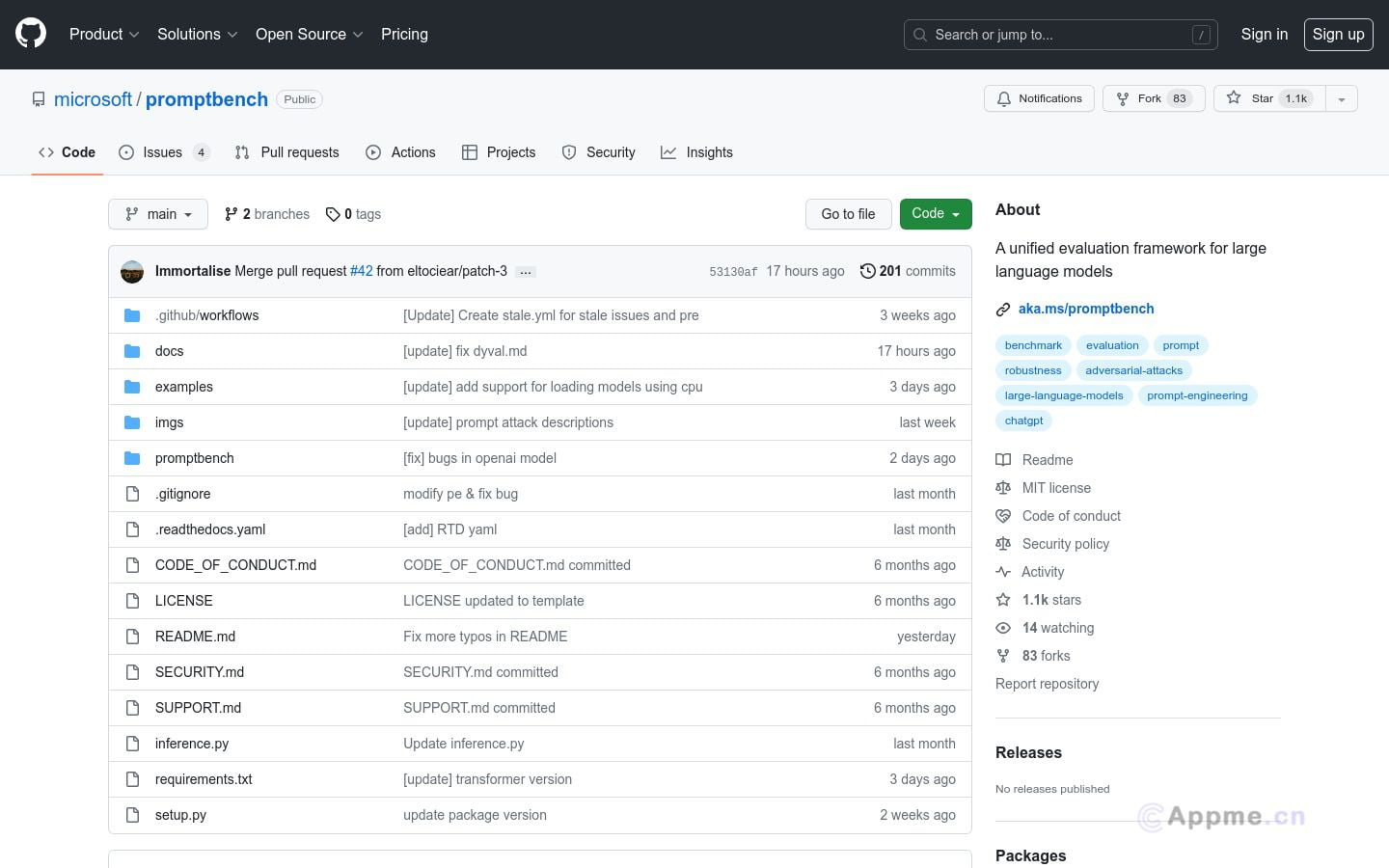

PromptBench是一款基于Pytorch的Python包,专门用于评估大型语言模型(LLM)的性能。它提供了用户友好的API,支持快速模型性能评估、提示工程、对抗提示评估和动态评估等功能。该工具使用简单,研究人员可以快速上手评估已有数据集和模型,也能轻松定制自己的数据集和模型。PromptBench适合需要评估语言模型性能、测试不同提示技术效果、检查对抗提示稳健性以及动态生成评估样本的用户群体。它可以帮助用户快速评估模型在各种基准上的表现,测试提示技术对性能的影响,构建对抗性提示评估模型稳健性,以及使用动态生成的样本进行全面评估。作为LLM评估的统一开源库,PromptBench为用户提供了一个强大而灵活的工具,助力语言模型研究和应用。