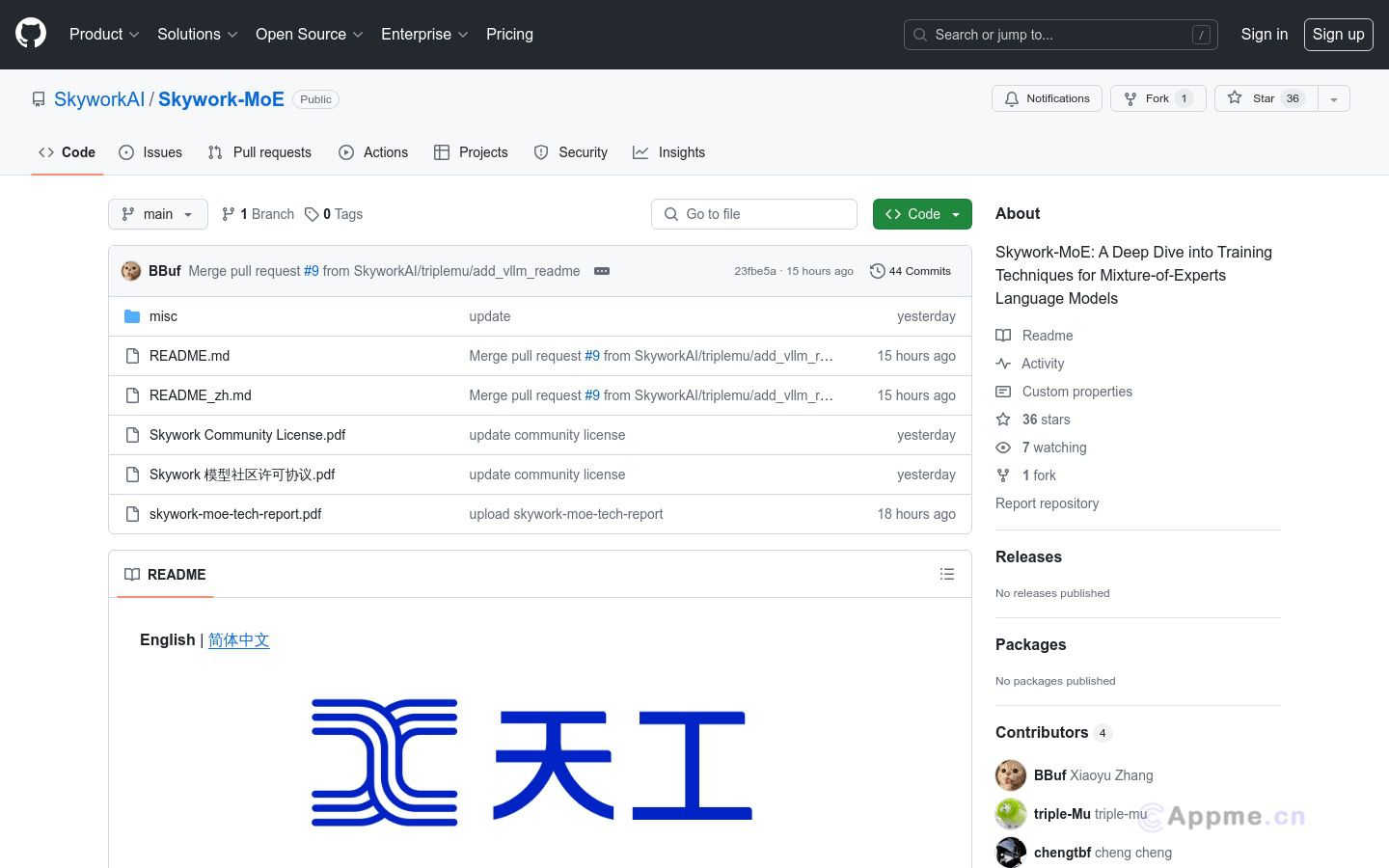

Skywork-MoE是一款先进的人工智能语言模型,具有146亿参数和16位专家的混合专家架构。该模型在性能上可与参数量更大的模型相媲美,甚至超越。其核心创新在于门控逻辑归一化技术,有效增强了专家多样性,以及自适应辅助损失系数,实现了更精细的模型调优。Skywork-MoE适用于需要高性能自然语言处理能力的研究人员、开发者和企业用户,可应用于文本生成、问答系统、语言翻译等多种场景。它不仅提供了出色的语言理解和生成能力,还以较小的计算资源实现了优异的性能,为用户带来更高效、更经济的AI解决方案。通过使用Skywork-MoE,用户可以显著提升其AI应用的质量和效率,同时降低运营成本。