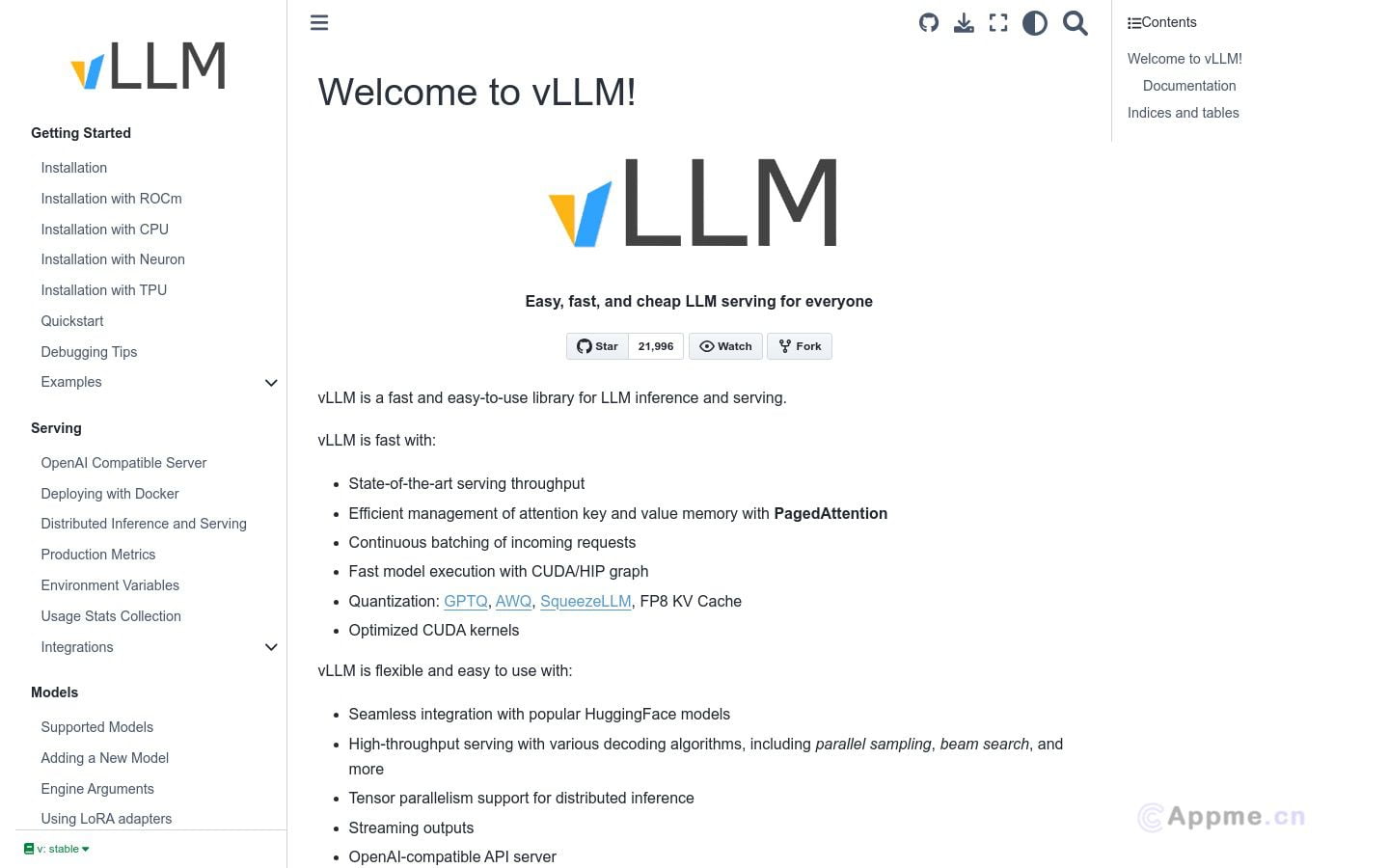

vLLM是一款为大型语言模型(LLM)提供高效推理和服务的先进工具。它通过创新技术如连续批处理、CUDA图执行和优化内核,大幅提升了LLM的推理性能和吞吐量。vLLM支持HuggingFace模型、多种解码算法、张量并行和分布式推理,并兼容OpenAI API。它还具备流式输出、GPU兼容性和实验性前缀缓存等特性。这款工具适合AI研究人员、模型开发者和需要部署LLM服务的企业使用。vLLM能帮助用户显著提高LLM推理效率,降低计算成本,实现更快速、更经济的AI应用部署,从而加速AI技术的实际应用和创新。